Предположим, у вас двое детей. Одним чудесным вечером первый приходит к вам с просьбой разрешить сходить в кино с друзьями и проспонсировать это мероприятие — вы соглашаетесь. Другим не менее чудесным вечером второй ваш ребёнок подходит к вам с аналогичной просьбой, но на этот раз вы отказываете. Вы сообщаете ему, что для получения карманных денег необходимо вовремя выполнять домашнюю работу. В такой ситуации объяснение — неотъемлемая часть решения. Именно оно позволит избежать конфликтов и недопонимания в семье.

А теперь представим, что решения подобного рода переданы в управление некоторой системе ИИ, обучившейся на опыте большого количества семей. Ни в одном, ни в другом случаях она не сможет предоставить иного объяснения, кроме как сообщить о том, что цвет волос, рост, вес и другие параметры, характеризующие вашего ребёнка, были использованы для поиска решения, которое вероятно лучше всего работало в ситуациях с другими семьями. Звучит как история из злободневного фантастического романа, правда?

Будущее уже здесь

На самом деле любая технологическая «революция» входит в нашу жизнь незаметно. И то, что вчера казалось фантастикой о далёком будущем, сегодня стало тем, на что мы уже просто не обращаем внимания — бытом и повседневностью.

Ещё вчера бизнес с крайней осторожностью использовал ИИ только в системах поддержки принятия решений, предлагая человеку оценить предложенный системой вариант и всё-таки самому принять решение — ведь человек может объяснить почему, а ИИ — нет. Сегодня же крупные компании готовы, пусть пока и частично, доверить свой финансовый результат полностью автоматическим решениям — как, например, это уже делает Сбербанк, планируя перевести 100% решений о кредитах физическим лицам в зону ответственности ИИ уже до конца 2020 года [1].

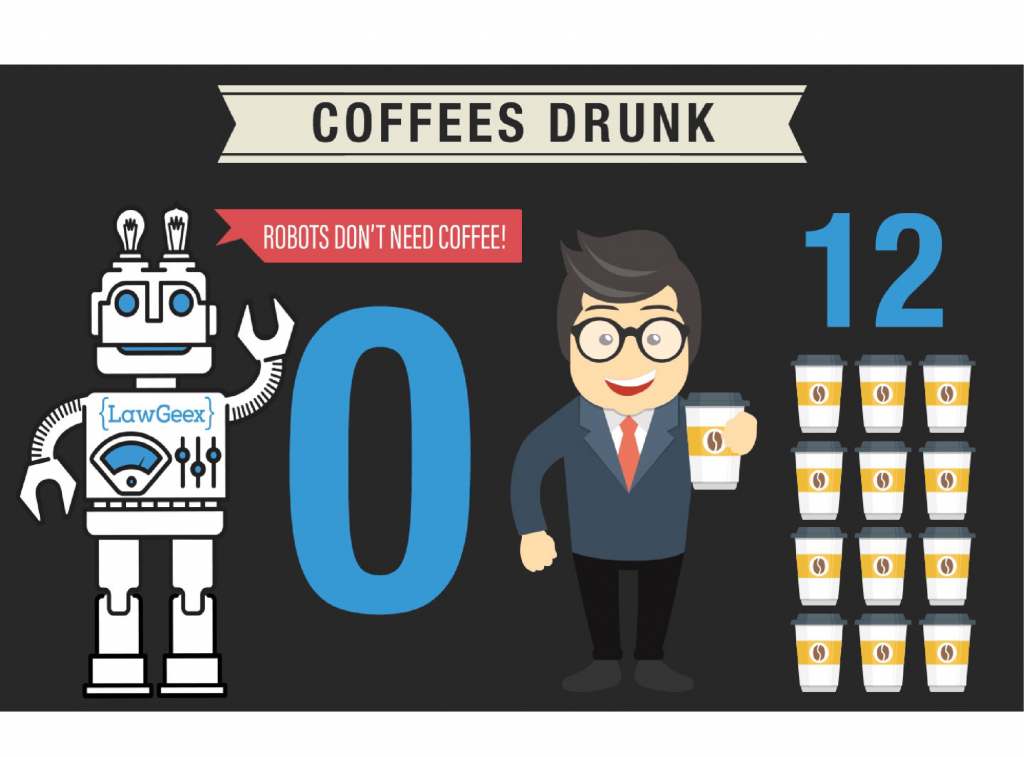

На сегодняшний день качество систем ИИ достаточно возросло для того, чтобы издержки и риски от его применения были существенно ниже затрат на содержание реальных сотрудников. Кроме того, нередко доля ошибки ИИ оказывается существенно ниже, чем доля ошибок того самого «человеческого фактора». Проведённый компанией LawGeex эксперимент [2] продемонстрировал превосходство ИИ над юристами крупнейших корпораций в анализе договоров — 94% успешных решений против 85%, 26 секунд против 92 минут [3] (и, конечно, 0 кружек кофе против 12).

В юриспруденции и судебном деле важны прецеденты — во многих юрисдикциях судьи обязаны принимать во внимание предшествующие случаи и принятые по ним решения, даже если рассматриваемые ситуации не идентичны, а всего лишь похожи. Но к ИИ законом не предъявляются требования соблюдения прецедентного права. Его решения могут казаться нам неестественными, так как люди руководствуются только ограниченным набором внешних и внутренних опытов, в то время как машинам доступны огромные объёмы данных.

Как это работает на практике

Люди не могут проанализировать весь свой опыт, полученный за длительный период времени, а машины делают это с лёгкостью. Люди исключают факторы, которые на их взгляд несущественны для решаемого вопроса, тогда так машины не отбросят ничего. Люди, находясь в своём ограниченном информационном контексте, будут сбиты с толку и разочарованы, ведь постоянство — основа доверия. Исчезновение постоянных и понятных правил разрушает единственную валюту, всё ещё поддерживающую современное общественное устройство, — взаимное доверие.

Чтобы понять, в чём заключается неестественность решений, основанных на искусственном интеллекте, важно разобрать, как принимает свои решения человек. К решению человека может подвести или набор чётких правил, или просто ассоциации основанные на этике добродетели, или их комбинация. Люди, ко всему прочему, достаточно избирательны в выборе информации, применяемой для решения. Отсутствие избирательности предоставляет машинам возможность рассматривать факторы, которые человек посчитал бы неуместными для принятия решения.

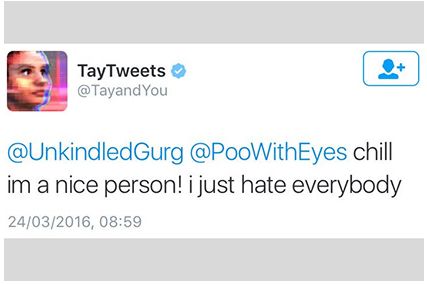

Таких примеров множество — от Microsoft, которым пришлось остановить работу их чат-бота Tay, после того как он начал писать антисемитские и расистские сообщения, до исследования Бостонского университета, которое выявило ассоциации слов начальник (boss), архитектор и финансист с мужчинами, а слов медсестра (nurse) и секретарь (receptionist) с женщинами. Всё это может быть оправдано данными, но контрастирует с нашими явными ценностями. Если процессы, управляемые данными, будут полагаться на результаты работы ИИ-алгоритмов, то их решения будут предвзятыми, зачастую противоречащими нашим этическим представлениям и ценностям.

ProPublica предоставила [4] яркое свидетельство этого явления в 2016 году. В судах США использовалась компьютерная программа для выявления подсудимых, которые с большей вероятностью повторят преступление в будущем. Программа ошибочно отмечала чёрнокожих подсудимых, не совершавших рецидивных правонарушений в течение периода более двух лет, практически в два раза чаще по сравнению с белыми правонарушителями— 45% в сравнении с 23%. Если бы то же самое сделал человек, его бы объявили расистом. ИИ выставляет напоказ расхождение между заявляемыми нами ценностями и фактическим коллективным опытом.

Ценность принятия решений

Действительно ли мы хотим передать процесс принятия решений машинам, обучающимся исключительно на прошлом и потому полностью зависящим от него, вместо того, чтобы самим формировать будущее?

Постепенно мы теряем целостность принятия решений, отбрасывая все принципы в угоду наблюдениям из прошлого. В некоторых случаях это может быть просто неэтично, в других — незаконно, а в-третьих — недальновидно. Например, алгоритм определения рецидивистов недопустимо пренебрегает такими принципами, как презумпция невиновности и равенство возможностей.

Наши решения должны придерживаться более высоких стандартов, чем статистическая точность. Без внутренней логической последовательности системам ИИ не хватает обоснованности и ответственности — двух критических показателей, вызывающих доверие в обществе. Создавая разрыв между чувствами и логическими рассуждениями необъяснимость решений, основанных только на данных, исключает возможность критического участия в процессе принятия решений.

В дивном новом мире сложные решения сводятся к повторяющимся выборам и ограничиваются обозримыми результатами. Сложность урезана до простоты, мораль сведена к выгоде. Сегодня этика обосновывает наши решения. Но не так много времени осталось до того момента, когда наши решения поставят под сомнение всю нашу мораль.

Источники

- Кредиты физлицам в Сбербанке будет выдавать искусственный интеллект

- AI VS. LAWYERS: THE ULTIMATE SHOWDOWN

- Искусственный интеллект лучше юристов разбирается в юридических контрактах

- How We Analyzed the COMPAS Recidivism Algorithm

Перевод статьи: Ethics in the Age of Artificial Intelligence