Deepfake — производное от «deep learning» — глубинное изучение и «fake» — подделка. Это механизм соединения и наложения одного изображения на другое, при этом чаще всего задействуются генеративно-состязательные нейросети (GAN).

Благодаря нейросетям стало возможно получать действительно реалистичные фото и видео событий, которых никогда не было в реальности. Например, синтезировать фальшивую видеозапись речи Трампа — или сгенерировать компромат. Изображения и видео, которые были созданы с помощью deepfake-технологии, часто используются в целях дезинформации и подрыва репутации человека.

Существуют простые способы отличить deepfake изображение от подлинного, например, внимательно рассмотрев задний фон изображения, детали, углы — так называемые «швы» картинки. Однако если синтез произведен качественно и с пост-обработкой, заметить его невооруженным глазом становится все сложнее.

В 2019 году группа исследователей создала новый алгоритм, который может обнаружить применение deepfake технологии в обработке изображений. Изначально алгоритм отличал фейки от оригинальных изображений с точностью от 71 до 95 процентов. Эффективность его зависела от того, какой набор данных использовался в выборке. Сегодня алгоритм работает только с изображениями, а специалисты всего мира уже разрабатывают механизм вычисления deepfake видео. Разработчики считают, что ненатуральность изображения легко читается по границам манипуляций, а значит, те, кто создает фейки, заботятся о том, чтоб все углы и шероховатости были максимально сглажены. В итоге уже обработанное фейковое изображение получается слишком гладким.

Чем опасны алгоритмы

«Deepfakes — это изображения или видео, которые были видоизменены — вы либо внедряете что-то в него, либо удаляете что-то из него — поэтому это меняет смысл изображения», — говорит Амит Рой-Чоудхури, профессор электротехники и вычислительной техники в Университете Калифорния, Риверсайд. Чоудхури — один из пяти авторов алгоритма вычисления deepfake материалов. По его мнению, новый алгоритм — это потенциальная защита от угрозы эпохи социальных сетей. К тому же, он считает, что пользователям нужно быть аккуратнее с подобными инструментами, ведь становится очень легко оказаться зависимым от работы алгоритма.

Если, допустим, новому алгоритму обнаружения deepfake будут слепо доверять, он сам может стать опасным оружием распространения ложной информации. «Я думаю, сегодня мы должны быть осторожны во всем, что связано с ИИ и машинным обучением», — говорит Рой-Чоудхури. «Мы должны понимать, что результаты, которые дают эти системы, не являются точными. Точность их работы не достигает даже 98 или 99 процентов, она намного ниже. Нельзя слепо верить машинам, это может привести к тяжелым последствиям.» Deepfake, по его словам, — это новый рубеж в кибербезопасности, а кибербезопасность — это постоянная гонка вооружений.

Устройство алгоритма

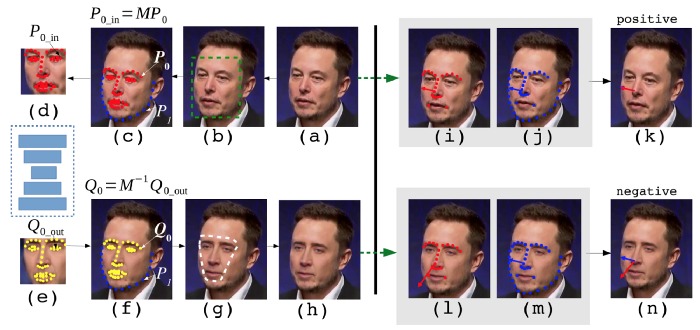

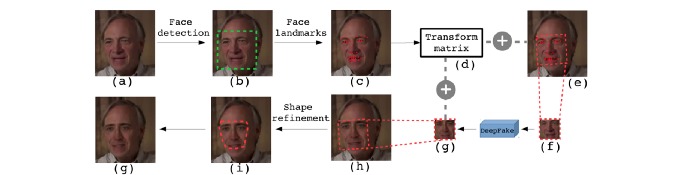

Также Рой-Чоудхури заявил, что в последней разработке команда использовала набор концепций, которые уже фигурировали в литературе отдельно друг от друга. Авторы объединили инструменты новым и потенциально мощным способом. В работе алгоритма задействуется разновидность рекуррентной нейронной сети, она фрагментирует изображение и изучает каждый пиксель отдельно. Через эту нейронную сеть прошло тысячи фейковых и подлинных изображений, и, благодаря накопленному «опыту», сеть способна выявить подделку на точечном уровне.

Совместно с рекуррентной нейронной сетью над изучением изображения работает серия фильтров кодирования. Говоря проще, система сжимает изображение, благодаря чему машина может рассматривать его на более целостном уровне. Анализ изображения с различных сторон выявляет элементы подделки, которые после выделяются красным цветом.

В свободном доступе

Уже в 2020 году компания Jigsaw выпустила платформу, которая позволяет всем желающим бесплатно проверить изображения на подлинность. Исполнительный директор организации Джаред Коэн рассказал, что инструмент проходил тестирование в более десяти информационных агентствах по всему миру, в частности в Animal Politico в Мексике, Rappler на Филиппинах и Agence France-Presse. «Вместе с Google Research и другими партнерами мы создали экспериментальную платформу под названием Assembler с целью проверки, как технология может помочь журналистам в выявлении и анализе поддельных фото и видео. Вдобавок, платформа создает пространство, где мы можем сотрудничать с другими исследователями, работающими над созданием технологии обнаружения».