Академическая честность — соблюдение правил, которые гарантируют, что автор не присваивал чужой труд, не искажал результаты исследования, везде указывал авторов. Это и есть следование принципам честной научной работы [8]. Академическая честность лежит в основе работы образовательных учреждений, а её нарушение — будь то плагиат, фабрикация данных или манипуляции результатами [7] — считается академическим мошенничеством. Этот феномен появился не сегодня. Так, первые примеры плагиата зафиксированы после появления книгопечатания [6].

Однако с развитием искусственного интеллекта (ИИ) традиционные представления о честности в науке и образовании пересматриваются. Широкое распространение нейросетевых технологий ставит новые этические вопросы: например, допустимо ли школьникам и студентам обращаться к чат-ботам при написании эссе? Как оценивать такие работы? Где помощь нейросети превращается в плагиат?

В СМИ тема ИИ часто освещается в мрачных тонах [3]:

- «Австралийские университеты объявили войну ChatGPT»;

- «Один из ведущих французских вузов запретил использовать ChatGPT во избежание плагиата»;

- «Нейросеть ChatGPT признали конкурентом мозгу человека».

Учёные даже придумали термин «GPT-непорядочность» — когда люди представляют работы, выполненные ИИ, как собственные [4]. Помимо этого, учёные опасаются снижения критического и творческого мышления из-за чрезмерного и недобросовестного использования чат-ботов [1]. В своё время учителя так же протестовали против использования поисковых систем. Говорили, что ученики из-за этого разучатся общаться и мыслить [3]. Но образование не разрушилось. Может, и с нейронными сетями история повторится?

С появлением нейросетей случаи академического мошенничества участились?

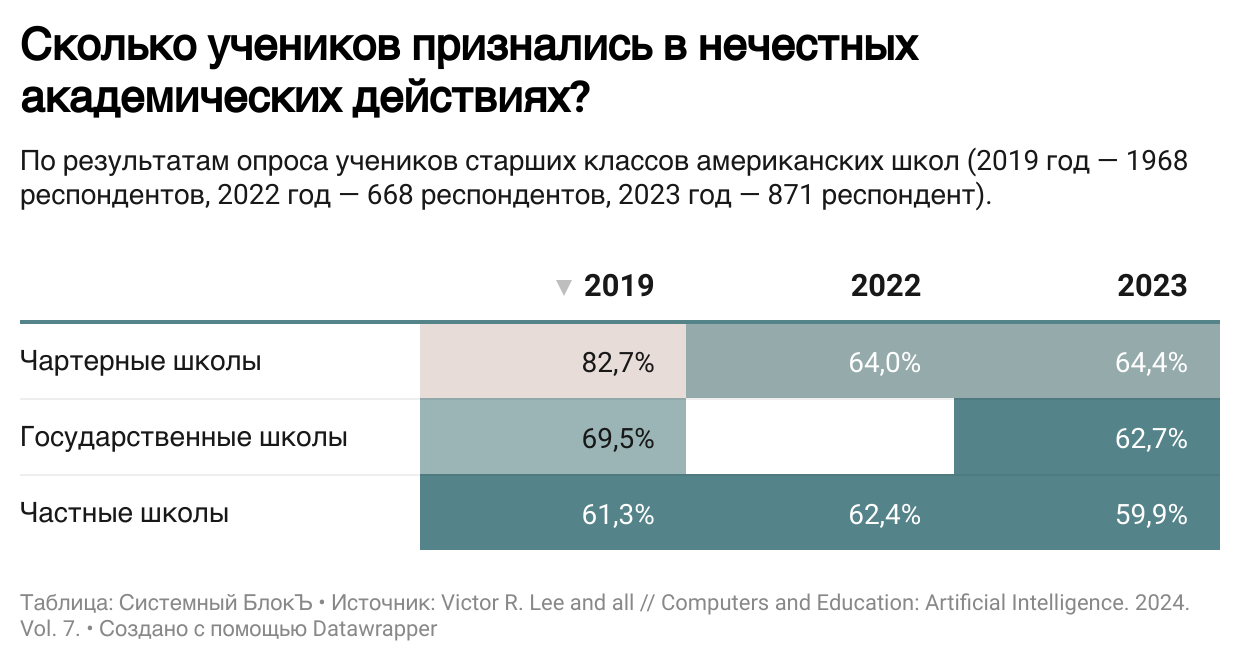

Нет. Ещё до широкого распространения ИИ школьники массово списывали. Об этом говорят результаты исследования [9]:

- В 2012 году опрос 23 000 американских старшеклассников показал: 75% списывали домашнюю работу, 52% — контрольные (Институт Джозефсона);

- Среди 3600 учеников школ США 95% признались, что хотя бы раз жульничали за год (Вангаард и Стивенс, 2011);

- Из 1400 студентов 97% списывали, а 26% делали это регулярно (Коннер и др., 2009).

Исследователи Стэнфордского университета, компании Challenge Success (CS) и «Стратегической консалтинговой группы DRZ» в течение нескольких лет до выхода ChatGPT опрашивали учащихся на тему списывания. В 2023 году, после выхода чат-бота от OpenAI и множества ему подобных, CS собрала данные, в том числе в тех школах, где уже проводила опросы.

Анкетирование было основан на методике, которую компания CS использует уже 10 лет. В анонимном опросе участвовали ученики старших классов государственных, частных и чартерных школ США. Можно было выбрать, на каком языке отвечать — английском или испанском. Родители или опекуны могли отказаться от участия ребёнка в исследовании.

Анкета состояла из 151 вопроса, а заполнение занимало около 20-40 минут. Ученики могли пропускать любые вопросы, а все ответы были конфиденциальны: они не передавались учителям и не влияли на оценки. Вопросы описывали конкретные действия: плагиат, обмен ответами, фальшивые оправдания. Шкала лжи помогала выявить недостоверные ответы.

Исследователи изучали: стали ли ученики чаще прибегать к нечестным методам, каким образом они используют ИИ и где, по мнению учеников, проходит грань между помощью и жульничеством. Исследование также охватывало школьный опыт подростков. Анализировались: участие во внеклассных мероприятиях, баланс учёбы и отдыха, поддержка (или, наоборот, давление) со стороны учителей, администрации или родителей. Это было нужно, чтобы увидеть полную картину: не просто «списывают ли ученики», но и почему они могут это делать — например, из-за стресса.

Результаты показали: несмотря на доступность ИИ-инструментов, уровень списывания не вырос, а даже немного снизился.

Как школьники используют нейросети?

Большинство учеников не используют ИИ для списывания домашних заданий.

Результаты опроса показали: генерация идей — нормально. 54-58% учеников считают допустимым использовать ИИ для мозгового штурма, поиска темы проектов и структурирования мыслей.

Оказалось, что 48-64% опрошенных против использования ИИ для написания фрагментов работы и редактуры готового текста. 86-95% учащихся высказались против автоматического создания всей работы.

Главный консенсус: ИИ-репетиторство приветствуется. 59,7% учеников государственных школ и 45,5% в частных школах уверены: нейросети должны быть легальными, когда объясняют сложные темы и концепции. Это единственный случай, где большинство за постоянное разрешение ИИ.

Итак, современные школьники готовы к интеграции ИИ в учёбу и сохраняют представление о честной работе. Школам только следует разработать чёткие этические правила, чтобы не отстать от технологической трансформации.

Как регулируют ИИ в вузах?

Данные о поведении школьников — первый шаг к пониманию роли искусственного интеллекта в образовании. В высшей школе вопрос этического регулирования стоит ещё острее, поскольку последствия недобросовестного использования нейросетей в научных работах могут быть гораздо серьезнее.

Передовые университеты быстро поняли: технологии не запретить — лучше идти по пути интеграции. Яркий пример — эксперимент НИУ ВШЭ и «Яндекса». Студенты гуманитарных направлений использовали YandexGPT для подготовки выпускных квалификационных работ. Участники отмечали, что, поручив нейросети рутинные задачи, они могли больше времени уделять творческим аспектам. При этом они указывали конкретные фрагменты текста, где им помогала нейросеть, а на защитах описывали своё взаимодействие с ИИ и процедуру проверки (фактчекинг) полученных от него данных.

Этично ли писать курсовые или учебные работы с помощью ИИ?

Один из вариантов ответа можно найти в «Белой книге искусственного интеллекта» [5], подготовленной «Альянсом в сфере ИИ»: да, можно. Согласно документу, такие инструменты можно использовать для составления черновиков и редактуры текста, однако они не должны подменять авторство. Ответственность за достоверность данных и конечный результат всегда несёт человек. Также обращение к нейросетям не должно нарушать внутренние правила, установленные учебным заведением.

Существует «Политика в отношении использования генеративного искусственного интеллекта в процессе обучения», разработанная Школой философии и культурологии НИУ ВШЭ. Свои правила использования ИИ студентами создал и МГПУ. В частности, в них отмечается, что нейросетевые инструменты нужно указывать в библиографическом списке как источник.

В совместном докладе [2] «Яндекс Образования» и НИУ ВШЭ приводятся результаты социологического исследования Tyton и Turnitin (2023 г.). Оказалось, что:

- почти половина студентов (49%) уже использует ИИ;

- 47% процентов студентов отмечают, что нейросети помогают им в учебе;

- 54% преподавателей считают, что умение пользоваться генеративными технологиями дает студентам карьерное преимущество.

В этом же докладе описывается опыт внедрения ИИ в ведущих университетах мира. Анализ их практик помогает определить общие направления регулирования. Ключ — не в запрете, а в прозрачности. Университет Эдинбурга призывает студентов к креативному применению ChatGPT и при этом настаивает на указание факта использования ИИ. Таким образом, нейросеть —это не автор, а инструмент, о применении которого в академической работе нужно сообщить по аналогии с цитированием источника.

Ведущие вузы делают ставку на обучение ИИ-грамотности, а не на борьбу со списыванием. Например, Оксфорд и Мичиганский университет создают открытые курсы и хабы, где объясняют, как работает ИИ, каковы его ограничения и этические риски. Университет Монаша прямо призывает преподавателей обсуждать этические аспекты технологий со студентами.

Новым востребованным навыком становится промптинг — умение грамотно формулировать запросы для нейросети. Умение задать точный вопрос теперь так же важно, как и способность найти ответ самостоятельно.

Технологический университет Сингапура предлагает изменение подходов к обучению. Опираясь на таксономию навыков Блума, университет призывает сместить фокус с заданий уровня «Запоминание» и «Понимание» на «Анализ», «Синтез» и «Оценку».

Правила использования нейросетей должны быть заранее определены и известны. Например, Университет Линдса в своих рекомендациях разделил учебные задания на три типа:

- Использование ИИ запрещено. Это касается заданий на получение и демонстрацию фундаментальных навыков (запоминание, понимание, критическое мышление);

- ИИ как помощник. Здесь можно обратиться к нейросети для генерации идей, написания черновика, объяснения сложной темы или отладки кода;

- ИИ как основной инструмент. Сложные задачи, которые требуют творческого мышления и критического подхода при работе с результатами, выданными нейросетью (например, сравнение и анализ контента, создание художественных произведений и т. д.).

Будущее — за заданиями, которые невозможно выполнить без человеческого участия. Среди них контекстуализированные проекты (например, анализ конкретной местной проблемы, требующий проведения полевых исследований), рефлексия и самоанализ, критическая работа, в том числе сравнение текста, написанного человеком, и генерации нейросети.

Честность как диалог

Академическая честность в эпоху ИИ постепенно перестаёт быть сводом запретов. Она превращается в диалог между студентами и преподавателями о том, как эффективно использовать технологии для получения новых знаний.

Главной целью — как настоящего, так и будущего — становится воспитание критического мышления и ответственности у студентов. Университеты, которые поняли это раньше других, не теряют академическую честность, а адаптируются к новой цифровой реальности.

Литература

- Абалян Ж. А., Пивнева С. В. Потенциал и риски использования искусственного интеллекта в высшей школе при обучении иностранному языку в профессиональной сфере // МНКО. 2024. № 3 (106). URL: https://cyberleninka.ru/article/n/potentsial-i-riski-ispolzovaniya-iskusstvennogo-intellekta-v-vysshey-shkole-pri-obuchenii-inostrannomu-yazyku-v-professionalnoy (дата обращения: 26.10.2025).

- Баранников, К. А. Искусственный интеллект и высшее образование: исследование Яндекс.Образования и НИУ ВШЭ / К. А. Баранников, М. С. Добрякова, Е. Г. Новикова и др. — М., 2025. URL: https://ethics.a-ai.ru/white-book/reader/

- Бермус А. Г. Преимущества и риски использования ChatGPT в системе высшего образования: теоретический обзор // Педагогика. Вопросы теории и практики. 2024. № 8. URL: https://cyberleninka.ru/article/n/preimuschestva-i-riski-ispolzovaniya-chatgpt-v-sisteme-vysshego-obrazovaniya-teoreticheskiy-obzor (дата обращения: 26.10.2025).

- Гасанова Р. Р., Романова Е. А. Искусственный интеллект в высшей школе: проблемы, возможности, риски // Вестник РУДН. Серия: Информатизация образования. 2024. № 4. URL: https://cyberleninka.ru/article/n/iskusstvennyy-intellekt-v-vysshey-shkole-problemy-vozmozhnosti-riski (дата обращения: 26.10.2025).

- Незнамов, А. В. Белая книга этики в сфере искусственного интеллекта / под ред. А. В. Незнамова. — М.: Nova Creative Group, 2024. — 200 с. URL: https://education.yandex.ru/aihighreport#usage-scenarios (дата обращения: 26.10.2025).

- Сысоев П. В. Этика и ИИ-плагиат в академической среде: понимание студентами вопросы соблюдения авторской этики и проблемы плагиата в процессе взаимодействия с генеративным искусственным интеллектом // Высшее образование в России. 2024. Т. 33. № 2. С. 31–53. DOI: 10.31992/0869-3617-2024-33-2-31-53

- Чёрных В. С., Селезнев И. Е., Скачкова М. А. Использование GPT студентами в академическом мошенничестве как этико-правовая проблема // Право и управление. 2024. № 9. URL: https://cyberleninka.ru/article/n/ispolzovanie-gpt-studentami-v-akademicheskom-moshennichestve-kak-etiko-pravovaya-problema (дата обращения: 26.10.2025).

- Atik A., Alzoraiki M., Milhem M., Atik R. A. Artificial intelligence in education: impact on academic integrity and transition to holistic assessment // Frontiers in Education. 2024. Vol. 9. P. 1470979. DOI: 10.3389/feduc.2024.1470979

- Lee V. R., Pope D., Miles S., Zarate R. S. Cheating in the era of generative AI: a survey of high school students’ cheating behavior before and after the release of ChatGPT // Computers and Education: Artificial Intelligence. 2024. Vol. 7. P. 100253. DOI: 10.1016/j.caeai.2024.100253