Робот — машина или что-то большее?

Современные гаджеты умеют взаимодействовать с человеком на естественном (т.е. человеческом) языке через голосовых помощников, таких как Алиса, Siri, Cortana, Alexa и т.п. Благодаря этому компьютеры и смартфоны стали восприниматься как активные участники социального взаимодействия.

Парадигма CASA (Computers are social actors) утверждает, что люди ожидают от искусственного интеллекта соблюдения тех же поведенческих и этических норм, что и от человека. У компьютера имеются схожие с человеческими социальные атрибуты: интерактивность, набор слов, способность выполнять задачи. Поэтому человек взаимодействует с ним, основываясь на своих типичных социальных привычках, и игнорирует асоциальную природу смартфона или компьютера.

Сексизм добрался до нейронных сетей

Так как модель коммуникации меняется, по отношению к голосовым помощникам формируются определенные стереотипы: например, гендерный. У Siri женский голос, потому что роль секретаря и ассистента часто ассоциируется с женщиной. Alexa от Amazon и Алиса от Яндекса — тоже девушки и говорят женским голосом. Mail.ru Group выпустила свою «Марусю». Помощники-мужчины, такие как Олег от Тинькофф-банка, в очевидном меньшинстве (к тому же неизвестно, что станет с гендером Олега после соединения Тинькофф-банка с Яндексом).

Также многие пользователи ассоциируют женщину с той, кто всегда поможет, проявит чуткость и внимание. Такая аналогия вызывает негативные эмоции у феминисток, которые утверждают, что это усиливает неравноправие в реальной жизни.

EQUALS — организация, выступающая за достижение цифрового равенства. В докладе EQUALS говорится, что к разговорным помощникам применяется насилие. 5% обращений пользователей носят сексуальный характер и содержат высказывания, которыми оскорбляют женщин. После обсуждения проблемы некоторые голосовые помощники стали идентифицировать себя как бесполых. Так на IT-фестивале SXSW в 2019 году был представлен, как утверждали создатели, «первый в мире гендерно-нейтральный» голосовой помощник Q.

Индивидуальность искусственного интеллекта

Все больше внимания разработчики уделяют личности голосовых помощников. Пользователь может определить характер робота на основе словесных и паравербальных сигналов в интерфейсе.

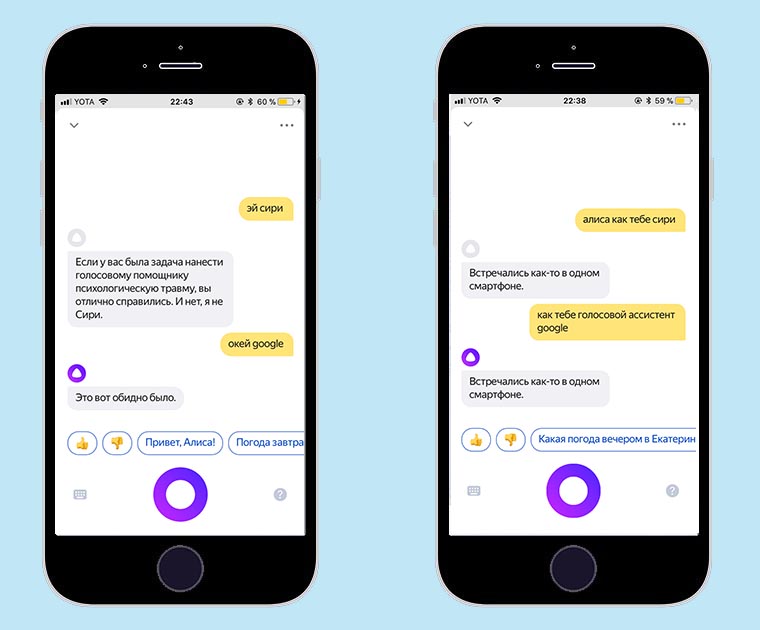

Например, голосовой помощник Алиса при каждом новом разговоре называет другой возраст, род деятельности и имеет непохожий на предыдущий набор характеристик. Попытки сделать бота более «человечным» привели к тому, что иногда ответы Алисы могут быть грубыми и напоминать хамство. Она может ответить на замечание человека: «ишь какая умная», «как смешно, придумай что-нибудь поумнее». Разработчики Яндекс просят пользователей сообщать о таком в службу поддержки и указывать, что ответ был обидный или оскорбительный.

Границы тесной дружбы

Хоть мы понимаем, что искусственный интеллект — продукт деятельности человека и лишен эмоций, мы воспринимаем его как потенциального собеседника из-за наличия голоса. Исследование «Computers in Human Behavior» эмпирически доказывает, что люди готовы раскрыться компьютеру больше, чем живому собеседнику. Alexa, Google Assistant и Алиса демонстрируют потенциал зрелого эмоционального интеллекта, когда пользователь говорит, что ему грустно или одиноко. Сопереживание и поддержка со стороны роботов привязывают человека к таким душевным беседам.

«Чем больше система похожа на человека, тем шире ожидания у людей», — говорит Жюстин Касселл, профессор компьютерных наук. Сюжет фильма «Она» не воплотился в жизни, и о романах с роботами говорить пока рано. Но эксперты опасаются, что душевные разговоры с голосовыми помощниками могут привести к шаблонному мышлению пользователей, ведь боты ограничиваются общими банальными высказываниями.