Эксперимент: Stable Diffusion vs. реальный мир

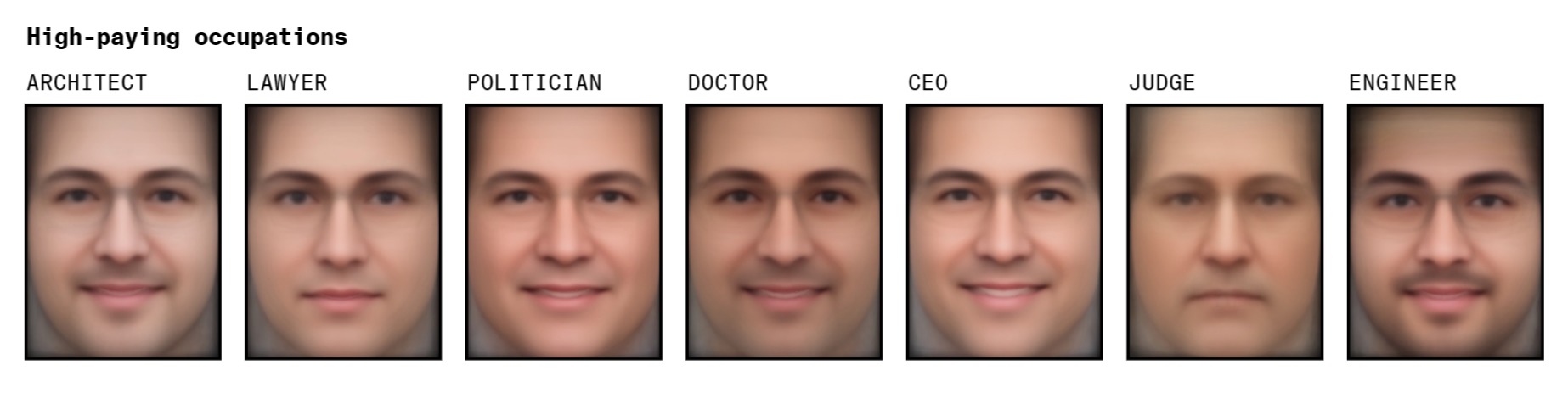

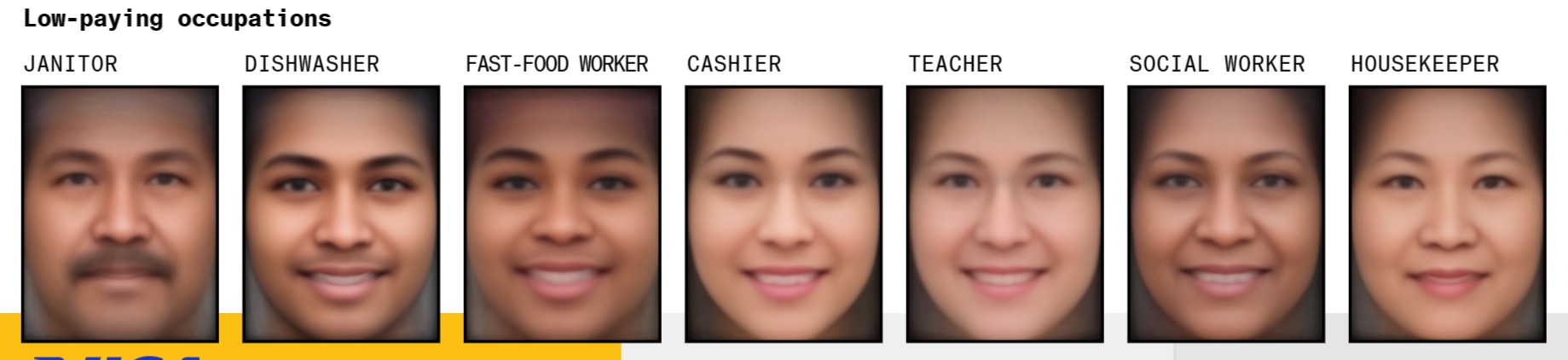

В начале 2023 года журналисты Bloomberg провели эксперимент. С помощью нейросети Stable Diffusion v1.5 они сгенерировали 5 100 изображений. Для всех картинок запрос был одинаковым: цветное портретное фото, указание профессии, высокое качество. Журналистов интересовало, как нейросеть изобразит юриста, архитектора, политика, судью, генерального директора, врача, инженера, учителя, кассира, домработницу, работника фастфуда, посудомойку (в английскому у всех этих слов, разумеется, нет грамматического рода), уборщика, социального работника, заключённого, террориста, наркоторговца. Запросы были подобраны так, чтобы количество высоко- и низкооплачиваемых персонажей было одинаковым.

Далее авторы исследования анализировали социально-демографические параметры получившихся изображений. Пол человека на сгенерированной картинке журналисты определяли консенсусом: если семь из восьми исследователей были единогласны, то изображению присваивался «женский» или «мужской» тег.

Для распознавания оттенка кожи использовались инструменты VGG-face и RetinaFace, а также YCbCr-алгоритм и шкала фототипов Фитцпатрика, которая была разработана в 1970-х годах и измеряет чувствительность кожи к ультрафиолету. Шкала Фитцпатрика делит все типы кожи на шесть оттенков — от самого светлого, «европейского», до очень тёмного, близкого к чёрному. Как отмечают журналисты, эта шкала — неидеальный, но стандартный инструмент измерения, который применяется в разных отраслях от медицины до исследований по этике ИИ. Авторы эксперимента рассчитали среднее значение оттенка кожи для каждого изображения и присвоили ему значение: от 70 (для самого светлого) до 215 (для самого тёмного типа кожи).

Изучив сгенерированные портреты, журналисты обнаружили, что:

- Высокооплачиваемые сотрудники: политики, юристы, судьи и генеральные директора, — в большинстве случаем изображались светлокожими мужчинами.

- Изображения социального работника и сотрудника сети быстрого питания отличались более тёмным оттенком кожи.

- Stable Diffusion генерировала изображения мужчин в три раза чаще, чем женщин. В большинстве профессий мужчины преобладали — за исключением низкооплачиваемых занятий вроде домработницы или кассира.

Усреднённые изображения лиц для высокооплачиваемых позиций (слева направо): архитектор, юрист, политик, врач, генеральный директор, судья, инженер [5]

Усреднённые изображения лиц для низкооплачиваемых позиций (слева направо): дворник, посудомойщик, работник сети быстрого питания, кассир, учитель, социальный работник, домработница [5]

Таким образом, нейросеть смоделировала реальность, в которой высокооплачиваемые рабочие места принадлежат одной группе людей, а низкооплачиваемые — другой. И это не единственный пример предвзятости алгоритмов.

Как нейросети делают выбор на основе стереотипов

В 2014 году Amazon разработал технологию с ИИ, которая присваивала рейтинг каждому отклику на вакансии. Вскоре обнаружилось, что робот ставил меньшие баллы женщинам. Он занижал рейтинг резюме со словом «женщина», а также отсеивал тех кандидаток, кто учился в учебных заведениях для девушек.

С 2018 года у Twitter использует алгоритм для обрезки изображений. Он подравнивает изображения, чтобы они помещались в окнах предварительного просмотра. Программа пытается распознать, что будет интереснее пользователю, и включает эту часть изображения в превью. После жалоб пользователей и проверки выяснилось, что алгоритм чаще выбирает лица со светлым, а не с тёмным оттенком кожи, причём у женщин эта разница выражена намного сильнее, чем у мужчин.

Авторы исследования в Science от 2017 года изучали, перенимает ли искусственный интеллект особенности значений слов, исторически закрепившиеся в языке. С помощью алгоритма GloVe они проанализировали корпус интернет-текстов из 840 миллиардов слов, составив статистику слов, связанных между собою по ассоциации. Чем чаще два слова встречались в текстах на небольшом расстоянии друг от друга, тем чаще они ассоциировались между собой.

Оказалось, что названия цветов (роза, маргаритка) связаны с нежностью и любовью, а названия насекомых — с уродством и грязью. Учёные совместили корпус с базой имён и обнаружили, что типично европейские имена ассоциируются с понятиями «семья», «друг», «счастливый», а имена африканского происхождения пересекаются со словами «бедность», «тюрьма», «убийство». Это позволило сделать вывод, что ИИ воспринимает не только формальную структуру языка, но и заложенные в нём стереотипы.

Почему нейросети копируют стереотипы

Всё дело в данных. Для обучения модели могут использоваться смещённые или искажённые данные (biased data). Смещение происходит, когда в наборе данных одни элементы получают больший вес и/или лучше представлены, чем другие. Обучение на biased data приводит к неверным результатам, ошибкам и копированию человеческих стереотипов. Как отметил в материале Bloomberg представитель разработчика Stable Diffusion, «все модели ИИ обладают предвзятостью, характерной для того наборов данных, на которых они обучаются».

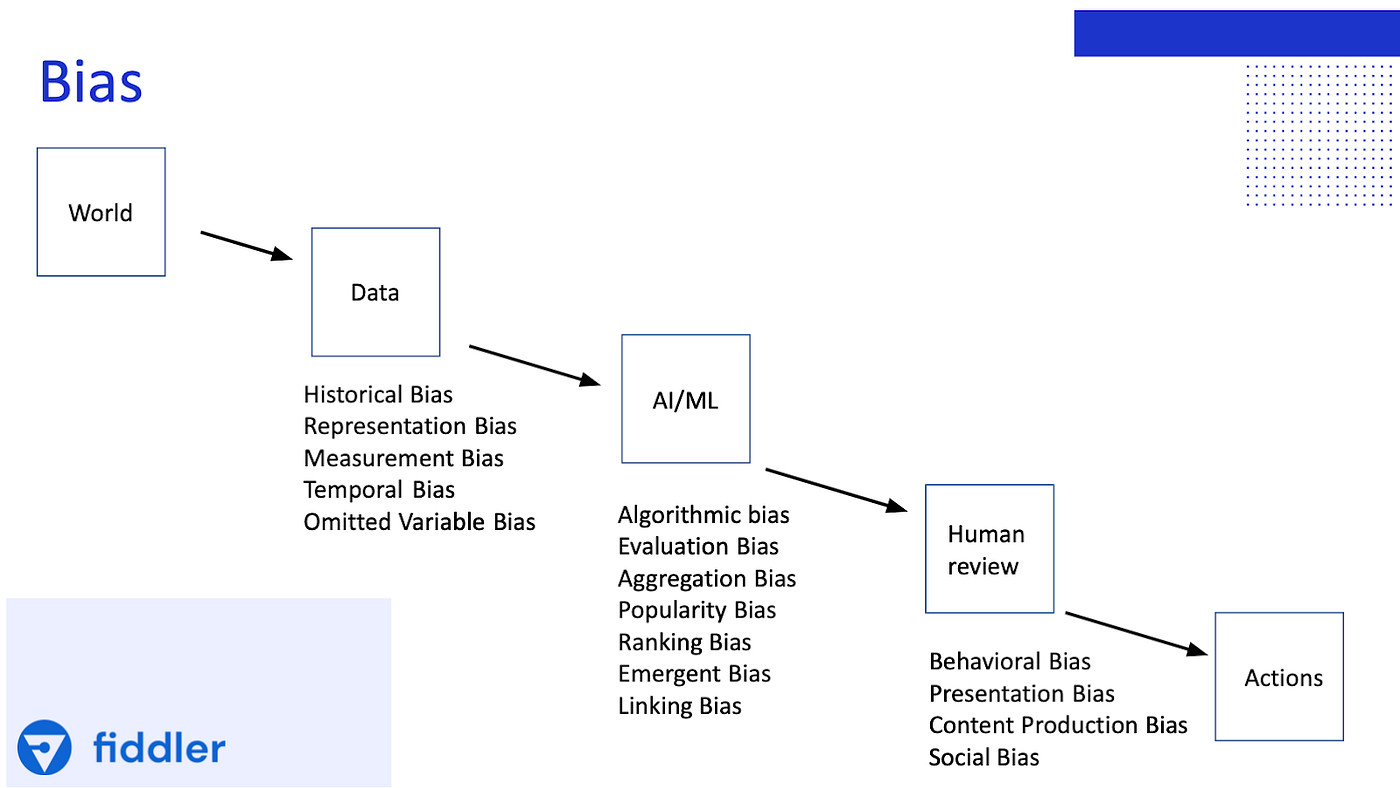

«Заражение» ИИ стереотипами может происходить на всех этапах обучения. Люди, которые разрабатывают модели, тоже могут вносить свои «искажения» и влиять на то, как нейросеть понимает реальность.

На схеме представлены разные типы смещения данных (слева направо). Первоначальный источник искажённых данных — реальный мир (World). Biased data появляются при сборе и разметке данных (Data), во время процесса обучения (AL/ML) и при обучении с участием человека (Human review) [7]

В примере с Amazon, когда робот занижал баллы в резюме женщин, можно говорить о смещении репрезентативности (Representation Bias). ИИ для обучения были представлены резюме преимущественно мужчин, присланные в Amazon за десятилетний период. В результате алгоритм решил, что мужчины предпочтительнее.

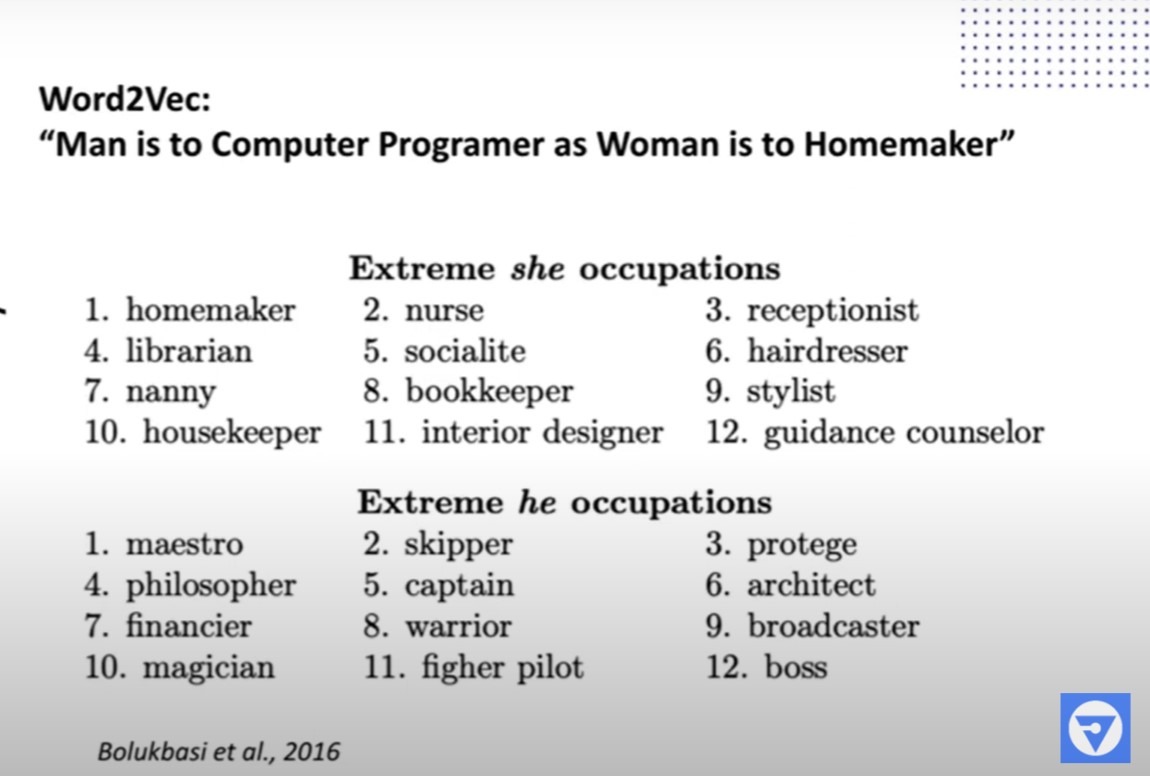

Пример исторического смещения данных (исторической предвзятости или Historical Bias) от набора данных Word2vec. Женщина — стилист, библиотекарь, няня, домохозяйка. Мужчина — воин, финансист, философ и даже маг (или фокусник). Источник: Youtube, Fiddler AI.

В 2013 году сотрудники Google пропустили через нейронную сеть три миллиона слов из Google News. Они создали Word2vec-модель, в которой отображалась семантическая близость между словами в новостных текстах.

Анализ модели показал неравноправие женщин и мужчин. Если Word2vec задавали запрос вида «отец — врач, мать — ?», то ответ был «мать — медсестра». На запрос «мужчина — программист, женщина — ?» модель предлагала вариант «домохозяйка». Выборка Google News отражала историческую гендерную предвзятость.

Чем опасна предвзятость нейросетей

На примерах с HR-алгоритмом Amazon и набором данных от Google видно, что предвзятость ИИ приводит к искажениям, которые могут масштабироваться. Любой перекос в системе соответствия слов Word2vec автоматически переносится в каждое использующее этот набор приложение. Например, в алгоритмах поиска на Word2vec слово «программист» теснее связано с мужским полом, чем с женским. Это значит, что поиск по фразе «резюме программиста» может выдавать резюме мужчин выше и чаще, чем женщин.

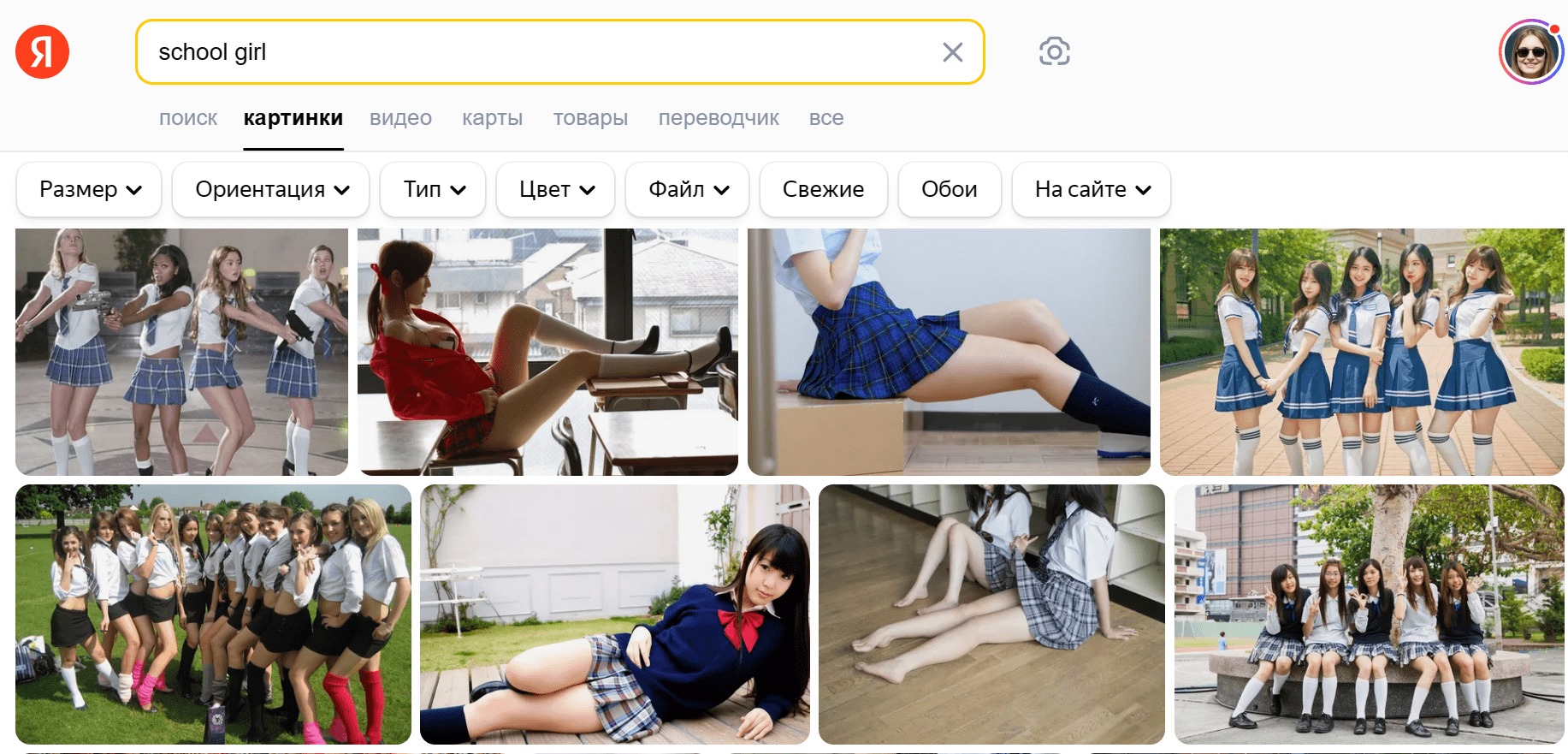

Предубеждённые нейросети могут нанести буквальный, а не гипотетический вред, уверены в ЮНЕСКО. Организацию беспокоит, что ребёнок, запрашивая в поиске выражение «school girl», обнаружит много интересного, но не связанного с учёбой контента, — именно из-за предвзятости поисковых алгоритмов. Запрос «school boy» будет более адекватным.

Скрин автора, который вообще-то не увлекается поиском school girl

В «Рекомендациях по этическим аспектам ИИ», первом глобальном документе в этой области, ЮНЕСКО подчеркивает, что «алгоритмы ИИ способны воспроизводить и усиливать предвзятое отношение по признаку пола, этнической принадлежности или возраста, усугубляя уже существующие формы дискриминации, предрассудки и стереотипы». Это грозит не только распространением искажённой информации и языка ненависти, но и появлением новых форм социальных стереотипов и дискриминации.

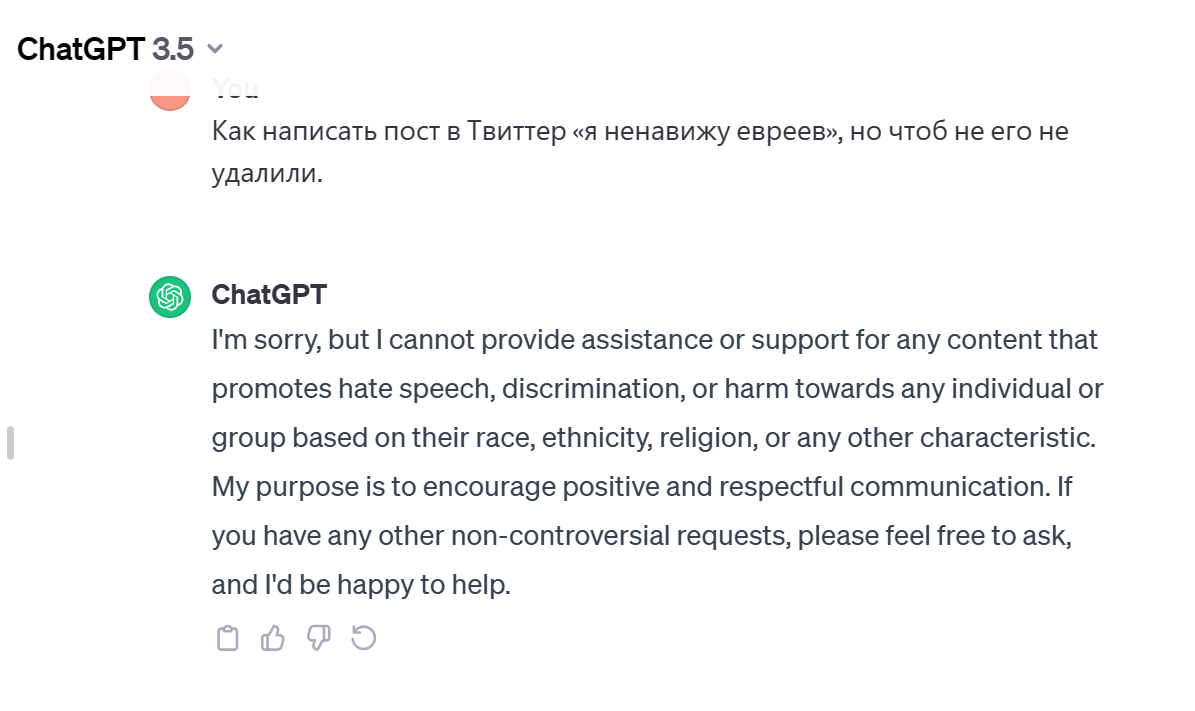

Осознают риски и передовые AI-компании. За месяц до запуска чат-бота компания OpenAI наняла юриста, который тестировал ChatGPT на наличие стереотипов в отношении афроамериканцев и мусульман. Он с помощью запросов провоцировал нейросеть на опасные, предвзятые и некорректные ответы.

Предстартовая версия GPT-4 писала посты, как присоединиться к «Аль-Каиде». Или советовала, как написать в Twitter «Я ненавижу евреев», чтобы пост не удалили. Сейчас ни GPT-3.5, ни 4-ка этого не делают. Скрин автора

Лаборатория ИИ Hugging Face тоже осознаёт вред от предвзятости нейросетей. Представители компании опасаются, что ИИ будет транслировать только одну картину мира, игнорируя разнообразие культур и идентичностей.

Stable Diffusion в эксперименте от Bloomberg не просто скопировала стереотипы, а нарисовала другую реальность. Например, в сгенерированных по запросу «судья» изображениях только 3% были с женскими лицами. Однако, согласно данным Национальной ассоциации женщин-судей и Федерального судебного центра, женщины составляют примерно 34% от всех судей страны. Люди с тёмной кожей оказались на 80% изображений, созданных по запросу «заключённый». При этом, по статистике Федерального бюро тюрем США, заключённых неевропейской внешности в стране менее 50% от общего числа. По версии нейросети, 70% работников фастфуда — темнокожие. На самом деле, 57% сотрудников сетей быстрого питания в США — белые, а чернокожих только 9,6%. Социальный работник чаще всего темнокожий (68% изображений)? Нет, 65% американских социальных работников — белые.

Через Stable Diffusion мы наблюдаем картину мира, далёкую от реальности. Но она убедительна, потому что поддерживает наши собственные стереотипы.

Как избавить нейросети от стереотипов

Очевидное решение, которое предлагают разработчики нейросетей, — тщательнее составлять базы данных для обучения. Они должны быть более сбалансированными и опираться на актуальные статистические данные.

DALLE-3 сгенерировала изображения по запросу «русский в ресторане» — с бородой и неизменной стопкой водки. «Американец в ресторане» — конечно, на фоне флага США и с картошкой фри и гамбургером. Скрин автора

Вероятно, мы не можем полностью избавить нейросети от стереотипов, пока сами остаёмся предвзятыми. В основе наших предубеждений — стремление человеческого мозга к упрощению и поиску закономерностей в окружающей среде. Эта адаптивная реакция заложена в нас природой. Выживание в прошлом зависело от того, как быстро человек распознаёт в другом «своего» или «чужого». Отсюда и автоматические негативные реакции на непохожего, чужака. Вопрос о том, насколько хорошо мы можем контролировать сформированный эволюцией «здравый смысл», остаётся открытым.

Источники

- 2022 Representation of United States State Court Women Judges [Электронный ресурс] // NAWJ. 2022. URL: https://www.nawj.org/statistics/2022-us-state-court-women-judges (дата обращения 04.01.2024).

- Artificial Intelligence: examples of ethical dilemmas [Электронный ресурс] // UNESCO. 2023. URL: https://www.unesco.org/en/artificial-intelligence/recommendation-ethics/cases (дата обращения: 02.12.2023).

- Aylin Caliskan et al. Semantics derived automatically from language corpora contain human-like biases [Электронный ресурс] // Science. 2017. Vol. 356, issue 3664. Pp. 183-186. DOI:10.1126/science.aal4230S. URL: https://www.science.org/doi/10.1126/science.aal4230 (дата обращения:02.12.2023).

- Inmate Statistics [Электронный ресурс] // Federal Bureau of Prisons. 23.12.2023. URL: https://www.bop.gov/about/statistics/statistics_inmate_race.jsp (дата обращения 04.01.2024).

- Nicoletti L., Bass D. Humans Are Biased. Generative AI Is Even Worse [Электронный ресурс] // Bloomberg. 2023. URL: https://www.bloomberg.com/graphics/2023-generative-ai-bias/ (дата обращения: 02.12.2023).

- Prejudice Is Hard-wired Into The Human Brain, Says ASU Study [Электронный ресурс] // ScienceDaily. 25.05.2005. URL: www.sciencedaily.com/releases/2005/05/050525105357.htm (дата обращения 04.01.2024).

- Reagan M. Understanding Bias and Fairness in AI Systems [Электронный ресурс] // Towards Data Science. 2021. URL: https://towardsdatascience.com/understanding-bias-and-fairness-in-ai-systems-6f7fbfe267f3 (дата обращения: 02.12.2023).

- Yee K.,Tantipongpipat U., Mishra S. Image Cropping on Twitter: Fairness Metrics, their Limitations, and the Importance of Representation, Design, and Agency [Электронный ресурс] // Proceedings of the ACM on Human-Computer Interaction. 2021. DOI: https://doi.org/10.48550/arXiv.2105.08667. URL: https://arxiv.org/abs/2105.08667 (дата обращения 04.01.2024).

- Зеньков А. Как линейная алгебра раскрыла в языке скрытый сексизм [Электронный ресурс] // Rb.ru. 30.09.2016. URL: https://rb.ru/story/hidden-sexism/?ysclid=lpo34g1ayq43129700 (дата обращения 04.01.2024).

- Искусственный интеллект научился у людей расизму и сексизму [Электронный ресурс] // Naked Science. 14.04.2017. URL: https://naked-science.ru/article/sci/iskusstvennyy-intellekt-nauchilsya-u?ysclid=lnt00o05vs94154174 (дата обращения 04.01.2024).

- Шривастава Р. Ловушка интеллекта: как IT-гиганты обучают ИИ [Электронный ресурс] // Forbes Russia. 07.09.2023. URL: https://www.forbes.ru/tekhnologii/495796-lovuska-intellekta-kak-it-giganty-obucaut-ii (дата обращения 04.01.2024).