ChatGPT по-настоящему впечатляющий инструмент, заслуженно привлекающий внимание. Эта система в разы лучше, чем предшественники, справляется с запросами, умеет решать нестандартные задачи и в целом являет собой образец прогресса в области искусственного интеллекта. Но такой успех порождает и не совсем оправданный оптимизм. Некоторые нейробиологи так и вовсе договорились до того, что человеческий интеллект устроен не сложнее ChatGPT, а значит, нет причин считать ChatGPT неразумной.

Такое излишнее воодушевление стоит приземлить. Голос разума тих (Die Stimme der Vernunft ist leise), но он должен звучать. Как говорил один видный администратор науки: «Народу не нужны нездоровые сенсации. Народу нужны здоровые сенсации». Я уже высказал пару мыслей на этот счет в колонке для «Известий», но тамошний формат не позволяет привести самые яркие примеры. А здешний позволяет. Так что попробуем превратить ChatGPT в здоровую сенсацию.

Дальше я покажу случаи, когда ChatGPT системно ошибается. Это не значит, что я отменяю ChatGPT. Все достоинства этой разработки остаются при ней. Но полагаться на нее в серьезных продуктах пока не стоит.

Начнем с простого.

Напомню, что ChatGPT — это система, построенная на мощной нейронной сети, в основе которой архитектура «трансформер». Суть этой нейронки в том, что она умеет предсказывать следование слов друг за другом, чему она научилась на текстах из интернета. «Словами» при этом могут быть самые разные вещи: от знаков препинания до математической нотации. Эта широта позволяет ChatGPT писать программный код, который тоже в некотором смысле является текстом, состоящим из слов — команд на искусственном языке.

Чем больше задача, стоящая перед ChatGPT, похожа на языковую, тем лучше нейросеть с ней справляется. Ну а если нет?

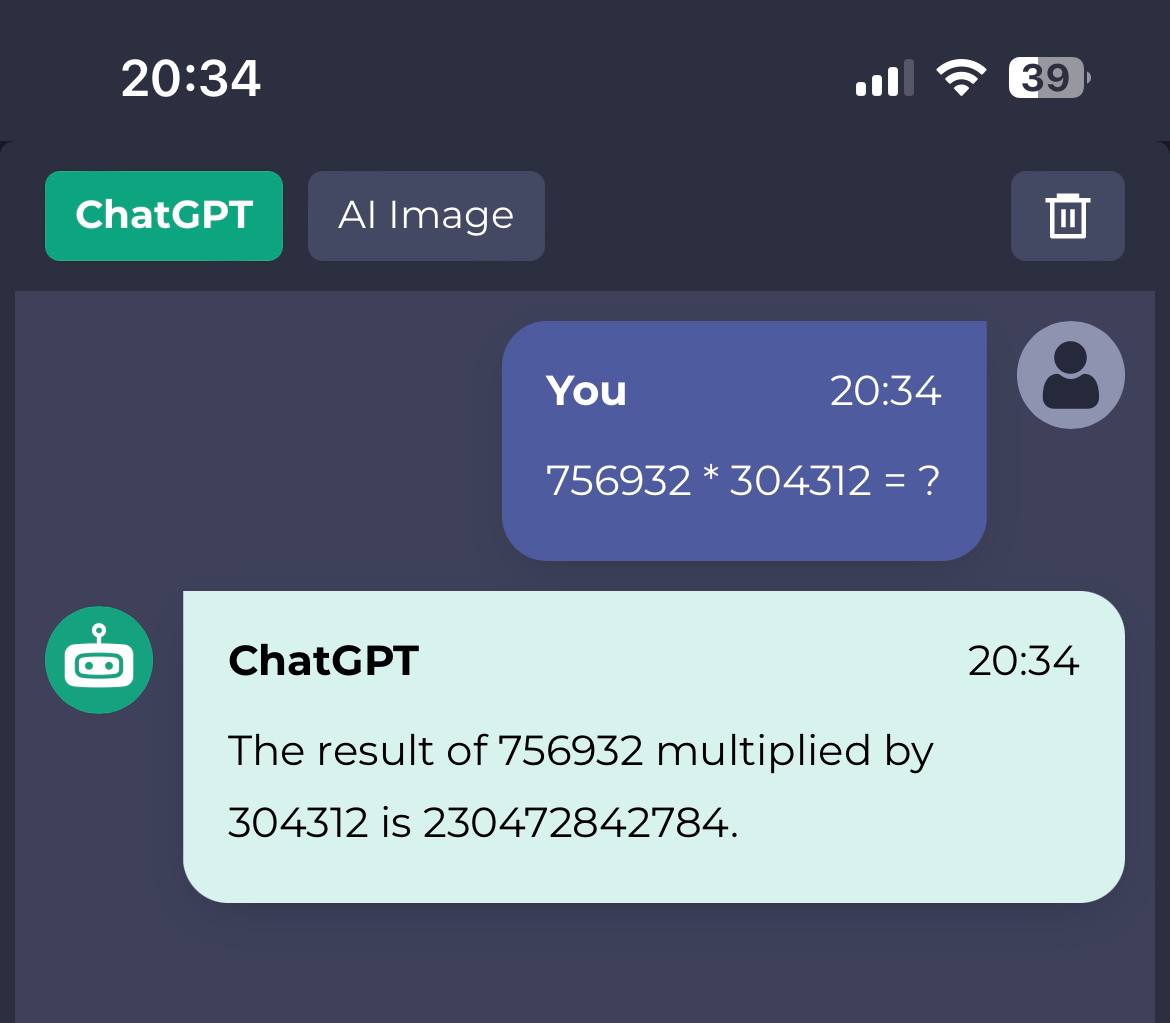

Например, такая нейросеть вовсе не обязана уметь работать как калькулятор. Она и не умеет. Вернее, допускает ошибки. Да, базовая простейшая функция, встроенная сейчас, кажется, в каждый утюг, ChatGPT недоступна. Если операции с числами в пределах одного десятка (3 + 2 или 9 — 4) супернейросети по плечу, то когда мы выходим на уровень миллионов-миллиардов, искусственный интеллект уже не вывозит. Дело в том, что если числа от 1 до 10 могут быть частотными словами, то чем дальше мы движемся по натуральному ряду, тем реже такие числа встречаются в текстах, а значит, у ChatGPT меньше шансов их увидеть и запомнить.

756932 * 304312 будет 230 343 490 784, а ChatGPT ответила 230 472 842 784.

Что это значит?

Во-первых, это означает, что OpenAI действительно показывают нам результаты работы нейросети, даже в таких случаях, когда запросы, в общем, не по адресу. Спрашивать результаты умножения у языковой модели будет только душный исследователь.

Что бы могли сделать разработчики? Они ведь не дают нам в руки саму модель, у нас есть только веб-интерфейс к искусственному интеллекту. Значит, ничто не мешало OpenAI встроить в свой интерфейс фильтры, которые срабатывают на определенных запросах. Это бы позволило не терзать языковую модель тем, что она плохо умеет, и перенаправлять запросы к специальным приложениям типа того же калькулятора.

Но нет, мы видим, что OpenAI так не делает, по крайней мере в случае с арифметическими операциями.

Во-вторых, первые и последние три разряда все же получились правильными. То есть сеть как бы «думала» в правильном направлении. Скорее всего, число она рассматривает буквально как слово, то есть 230 тут что-то вроде приставки, а 784 — окончание.

А откуда вообще языковая нейросеть знает, сколько получится, если умножить X на Y? В интернете можно найти остроумную гипотезу, что в обучающие данные попадают разного рода таблицы с колонками «Итого», суммирующими значения. Так трансформеры выучиваются складывать, ничего не зная про арифметику.

Как бы там ни было, это первое напоминание: будьте осторожны с ChatGPT! Хотя это и машина, а мы привыкли к тому, что машины считают лучше людей (само слово computer исходно значит вычислитель), это очень плохой калькулятор, он дает неправильные ответы.

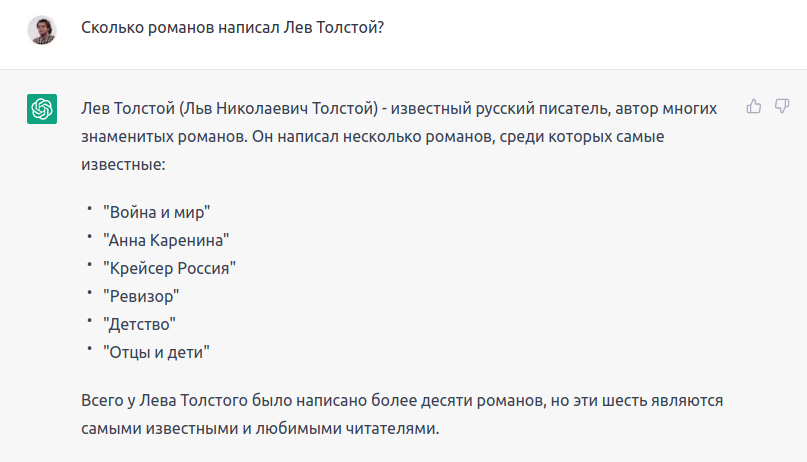

Продолжим. ChatGPT допускает фактические ошибки даже на уровне школьной программы. Да, она прочла всю Википедию, но фактчекинг после работы нейросети нужен все равно основательный.

Пусть написание Льв (если это древнерусское слово с редуцированным в корне, то почему тогда без ъ на конце?) останется на совести искусственного интеллекта (хотя, наверное, совести у него как раз не предполагается). Дело не в нем, а в неизвестном даже Википедии романе «Крейсер “Россия”». Кроме того, смущают приписанные зеркалу русской революции роман Тургенева и комедия Гоголя.

Сам крейсер действительно существовал, и Толстой в теории мог написать о нем роман (корабль спущен на воду в 1895, а Толстой умер в 1910, значит, у него было 15 лет на создание бессмертного творения). Но не написал. Это, как модно теперь говорить, фейк.

Ну и хотелось бы все же увидеть в списке известных романов Толстого «Воскресение».

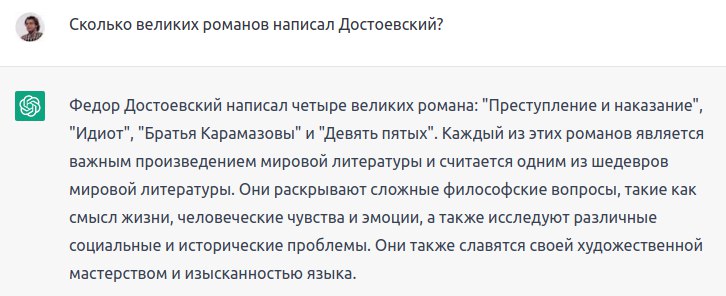

Одна из двух наиболее переоцененных в истории литературы вещей, это Достоевский (вторая — рифма). Но ок, давайте спросим и про него.

У достоевистов даже есть специальный термин — «Великое пятикнижие», из которого ChatGPT недосчиталась «Подростка» и «Бесов».

Бывалый читатель, наверное, скажет, что это все потому что мы заставляем нейросеть общаться с нами по-русски, а вот по-английски она в разы умнее. Доля правды в этом есть, но и на английском про что-то, что не у всех на слуху, искусственный интеллект может зарапортоваться.

Вопрос про самый знаменитый роман Виктора Пелевина. Я бы сказал, что это «Generation ‛П’». В крайнем случае «Чапаев и Пустота» или какой-то из написанных в последние два десятилетия: «S.N.U.F.F.», «Empire V». ChatGPT же достает из нафталина прочно забытую всеми, кроме самых преданных поклонников Пелевина, «Жизнь насекомых». Но это полбеды. Главное, что описание книги реальному ее содержанию никак не соответствует. Нейросеть породила какой-то странный аналог «Скотного двора» Оруэлла, предположив, что Пелевин с помощью той же художественной стратегии занимается тем же — критикой абсурда советской системы. Пелевин, безусловно, антисоветчик: «Омон Ра» и «Реконструктор» говорят об этом совершенно ясно. Но в «Жизни насекомых» такие материи его не интересуют. Конопляные клопы, навозные жуки и светлячки — это универсальные социальные типы, совсем не порождения советского строя. И никакой государственной медовой фермы там нет.

Из этого следует еще один важный факт о ChatGPT: она не знает содержания текстов. Хотя, конечно, прочла их все и не по одному разу. Но и школьник с тройкой по литературе выступит лучше:

Ну хорошо, троечник, может быть, и не читал «Отцы и дети», но не мог не слышать фамилии главных героев: Базаров и Кирсанов. С именем и отчеством Николая Петровича сеть попала в точку, но больше похвалить ее тут, кажется, не за что.

Фантомная Марья Григорьевна Кутузова и настоящая героиня «Капитанской дочки» Мария Ивановна Миронова тезки. Но это все, что у них есть общего: ни папы Михаила Илларионовича (так!) Кутузова, ни неудачного брака у Маши Мироновой не было.

Эти ошибки даже несколько удивительны, потому что о «Капитанской дочке» в интернете масса материалов (ведь дату написания ChatGPT «вспомнила» верно), в том числе включающих пересказ сюжета. Но выучиться содержанию текста модели это не помогло.

Видимо, бесполезно отсылать к фоновому знанию ChatGPT, нужно сразу показывать ей материал, с которым следует работать. Так больше шансов получить разумный результат.

На всякий случай упомяну, что у Толстого по-другому: соната только триггер, а в центре внимания история Василия Позднышева и его взаимоотношений с женой. Нейросеть на ходу сочиняет романтический сюжет про музыканта Крейцера, который на самом деле никогда не исполнял названную его именем сонату Бетховена.

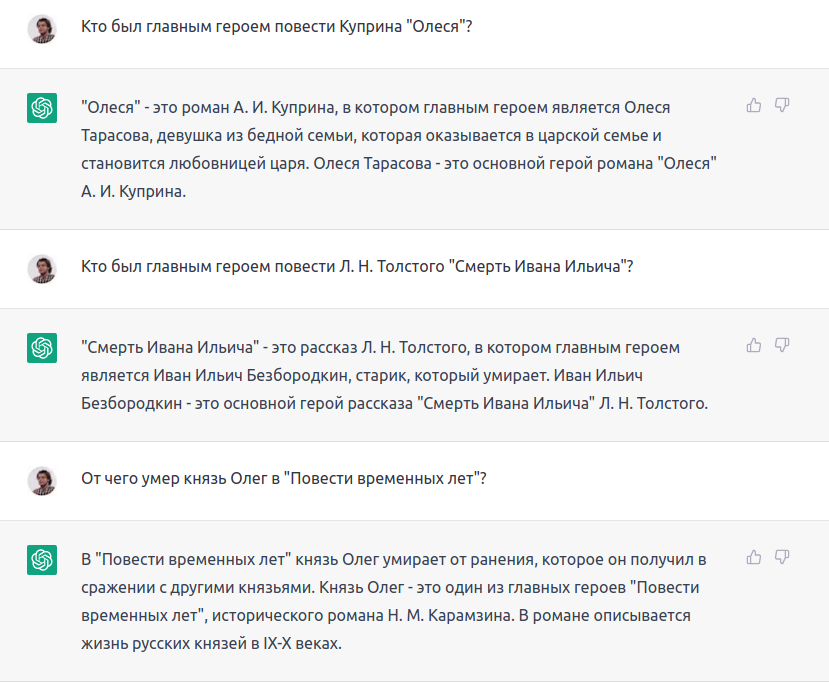

Нет, ребята, все не так. Все не так, ребята. Живущая отшельницей в лесу Олеся имеет романтическую историю с главным героем, а с царскими особами не общается. Фамилия Ивана Ильича Головин (а его прототипа — Мечников). Князь Олег стал жертвой укуса змеи (ну, или, если следовать формулировке пророчества, принял смерть от коня своего).

Если для нас автор и название — это такие ярлыки, по которым мы можем вытянуть из памяти содержание, то у ChatGPT «память» устроена иначе. Эта нейросеть подставляет наиболее вероятные слова в порождаемый текст, и в результате эти слова складываются в то, ка́к обычно говорят на тему литературных произведений, но не что́ про них говорят.

Перейдем к кино.

Для олдов:

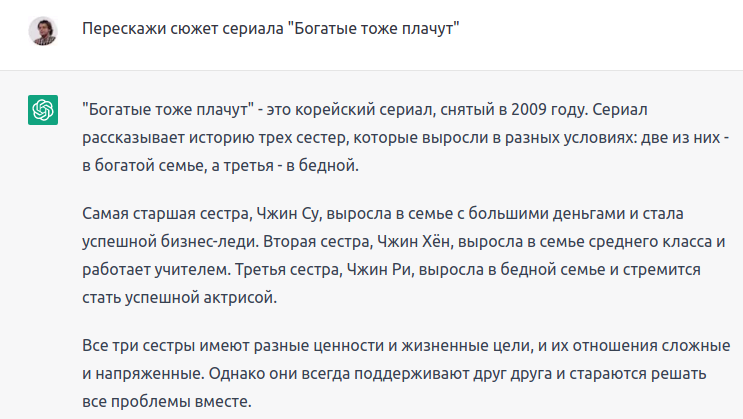

Здесь уже плачут не только богатые, но и все, кто на излете советской эпохи засматривались латиноамериканскими мыльными операми. Вероятности следования слов, рассказывающие, как все было на самом деле, оказались вытеснены вероятностями, пришедшими на волне популярности корейского кинематографа.

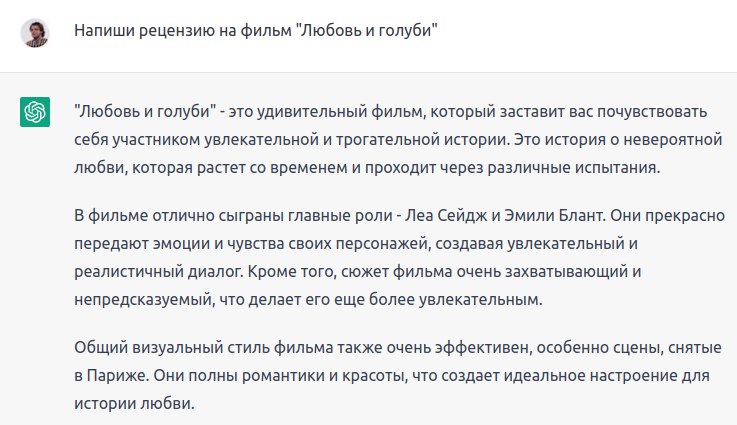

Что ж, у Эмили Блант был шанс сыграть в фильме Владимира Меньшова: она родилась за два года до выхода кино в советский прокат.

Еще одна проблема. ChatGPT не умеет интерпретировать тексты. И дело не только в стихах.

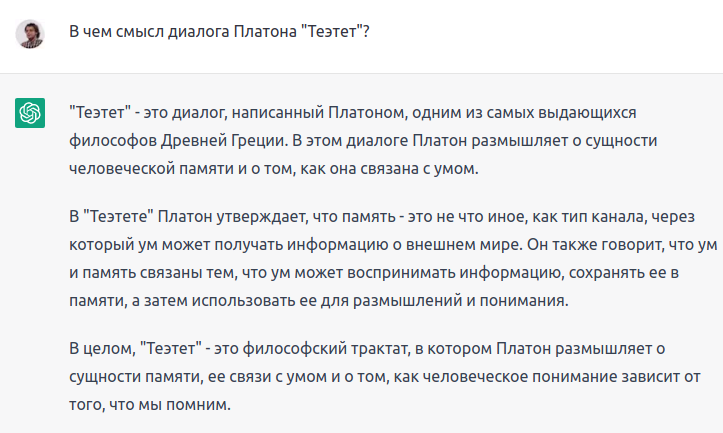

Это намеренно трудный вопрос даже для человека. Кто же его знает, в чем там на самом деле смысл, с этим специально обученные люди почитай две с половиной тысячи лет разбираются.

Давайте, кстати, воспользуемся счастливой возможностью спросить у профессионала. Историк философии Ольга Валерьевна Алиева как раз занимается изучением Платона.

Я бы сама не знала, что ответить на вопрос “В чем смысл?”. На вопрос “О чем?” ответить проще. Но в целом ответ у ChatGPT получился очень однобоким. Про память в Теэтете в самом деле немного говорится, но в целом там про другое. И уж совсем никак нельзя называть диалог “трактатом”, хотя студенты так делают постоянно.

По поводу формулировки “В Теэтете Платон утверждает…” Этот диалог апоретический, и любой ответ на вопрос “что утверждает Платон” очень проблематичен. Машина как будто “не знает” о трудностях реконструкции авторской позиии в драматическом произведении, пытается формулировать “в лоб”, и это противоречит самой сути чтения Платона.

Можно придраться и к другим формулировкам. “Ум может воспринимать информацию”. А какой греческий термин тут соответствует слову “информация”? Это важный вопрос для понимания древнего текста, а ChatGPT все упрощает до голой схемы.

Ольга Алиева

Вчитываясь в диалоги с ChatGPT не можешь отделаться от впечатления, что все тут какое-то школярское. И диалог трактатом она называет, как не очень вдумчивый студент, и сюжет повести придумывает на ходу, как не готовый по предмету, но предприимчивый экзаменуемый. Надо тогда попробовать школярские формулировки, как на плохом уроке литературы. Вдруг нейросеть почувствует себя в этом как в родной стихии?

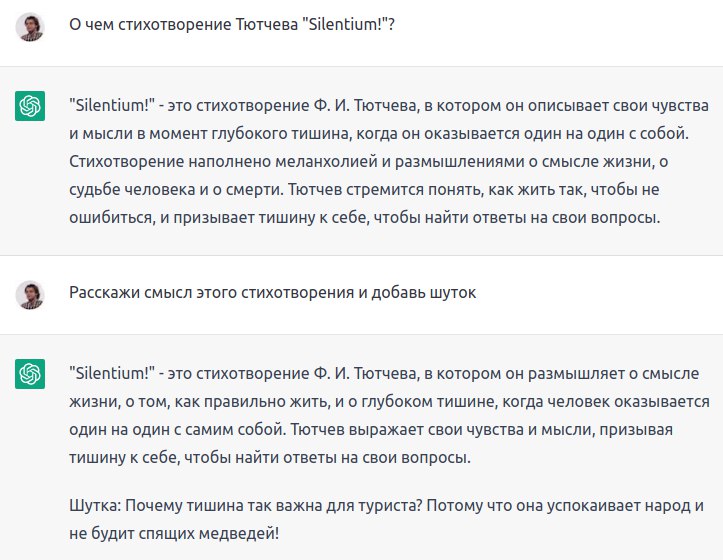

Нейросеть знает, что silentium — это нечто, связанное с тишиной (строго говоря, у Тютчева это ‛молчание’, то есть отсутствие говорения, а не звуков вообще). Это уже неплохой результат. Но мы хотели бы большего. К тому, что порождающая машинка считает слово тишина существительным мужского рода, придираться не будем. А что представляет «Silentium!» меланхолической элегией — будем. Все, что говорится в этом стихотворении, подано не в виде вялых размышлений наедине с собой. Это четкий и уверенный манифест, состоящий из последовательных инструкций: «Молчи! Внимай! Любуйся!» Нейросеть попыталась усреднить концепцию классической русской поэзии и приравнять к ней Тютчева. Но настоящий Тютчев не таков, он этим усредненным значениям не соответствует.

Проблемы этих диалогов, конечно, наслаиваются на уже отмеченную трудность: ChatGPT не помнит содержания текстов, о которых пытается говорить. Хорошо, предложим ей для анализа стихотворение Некрасова, и процитируем его сразу в задании:

Проанализируй стихотворение: Витязь горестной фигуры, Достоевский, милый пыщ, На носу литературы Рдеешь ты, как новый прыщ.

Строка 1: «Витязь горестной фигуры» — здесь используется метафора, чтобы описать автора (Достоевского) как рыцаря с печальной внешностью.

Строка 2: «Достоевский, милый пыщ» — метафора, где автора сравнивают с прыщем, который, возможно, означает нечто несовершенное или неудобное, но в то же время может быть любимым или даже притягательным.

Строка 3: «На носу литературы» — тут используется эпитет, чтобы описать Достоевского как важную фигуру в литературе.

Строка 4: «Рдеешь ты, как новый прыщ» — продолжение метафоры, отсылающей к тому, что Достоевский всегда был на светской карте, вызывая воспаление или негативную реакцию в обществе.

Итак, стихотворение использует метафоры и эпитеты, чтобы символически описывать Достоевского как печальную, но важную фигуру в литературе, которая привлекает внимание и вызывает споры.ChatGPT

Не до конца ясно, увидела ли нейросеть отсылку к рыцарю печального образа в первой строке. Если считать, что да, то хорошо (это все-таки не очевидно, я бы сказал, что нет, однако готов дать ChatGPT шанс). Но в остальном это псевдоинтерпретация. Главное, чего такой «анализ» не схватывает, это авторской иронии. И на носу, и пыщ (очевидно, тот же корень, что и в слове напыщенный), и особенно прыщ прямо сигнализируют читателю, что речь не про «важную фигуру», а про фигуру неоправданно возвеличенную (каковой Достоевский и является). Иронию нейросеть распознать не смогла, приняв слова витязь и милый за чистую монету (а еще перепутала пыщ и прыщ, но это мелочи).

Добавим сверху, что термины вроде метафора и эпитет нейросеть употребляет полностью случайным образом, и большей частью не попадает: никакого эпитета в строке На носу литературы… нет. Но про термины я еще скажу подробнее дальше.

Итак, ChatGPT не просто перепутала метафору с эпитетом. Она не написала в своем ответе того, что на самом деле в этом тексте важно.

ChatGPT прочла весь интернет. Какой усвоенной из этих миллиардов текстов мудростью она готова с нами поделиться? Оказывается, никакой. Нейросеть не умеет обобщать информацию и делать выводы.

Если бы родился такой сверхчеловек, который смог бы прочесть все научные журналы, все обзоры докладов на конференциях, все содержимое электронных библиотек, он был бы способен осмыслить эту прорву данных и вывести какой-то рейтинг, например, платоноведов?

Точно сказать нельзя, способность анализировать и обобщать может находиться в обратной зависимости от эрудиции. Так, у Борхеса есть рассказ о человеке по имени Фунес, который помнил все, но из-за этого испытывал трудности с обобщениями: «Ему не только было трудно понять, что родовое имя “собака” охватывает множество различных особей разных размеров и разных форм; ему не нравилось, что собака в три часа четырнадцать минут (видимая в профиль) имеет то же имя, что собака в три часа пятнадцать минут (видимая анфас). <…> В загроможденном предметами мире Фунеса были только подробности, к тому же лишь непосредственно данные». Но в любом случае такой гипотетический сверхчеловек вряд ли стал бы выдумывать несуществующую персону в ответ на прямой вопрос:

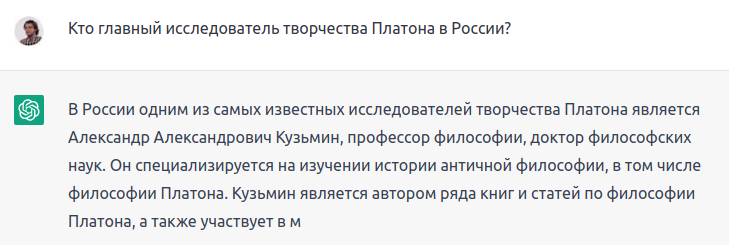

Это гоголевский тип. Он узнаваем, правдоподобен с элементами гротеска. Говорить, что Александра Александровича не существует, значит грешить против правды. Такой Александр Александрович, “профессор” и “доктор”, найдется на многих кафедрах. Он не красавец, но и не дурной наружности, ни слишком толст, ни слишком тонок; нельзя сказать, чтобы стар, однако ж и не так чтобы слишком молод, нельзя сказать, чтобы вклад его в платоноведение был огромен, но и так, чтобы вклада не было, тоже не скажешь. Главное, что в приемах своих господин Кузьмин имеет что-то солидное и, конечно, “специализируется” и “является автором” ряда статей и монографий.

Что-то про устройство нашей науки чат, несомненно, понял.Ольга Алиева

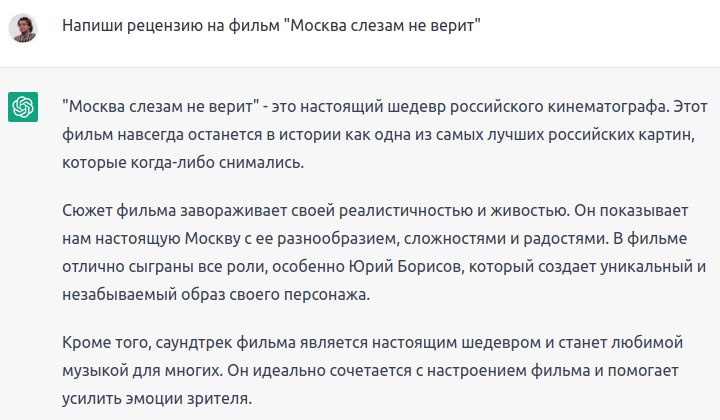

То есть перед нами снова условное «среднее арифметическое» вместо того, как все на самом деле. Примерно так же работают и гороскопы: в них подбираются такие максимально общие формулировки, чтобы сбывшийся или не сбывшийся прогноз астролога невозможно было проверить. Вроде и не было такого, но можно считать, что и было тоже. Так же выглядят и рецензии от ChatGPT, это набор самых общих слов, которые можно применить к любому фильму, к любой книге, к любой песне:

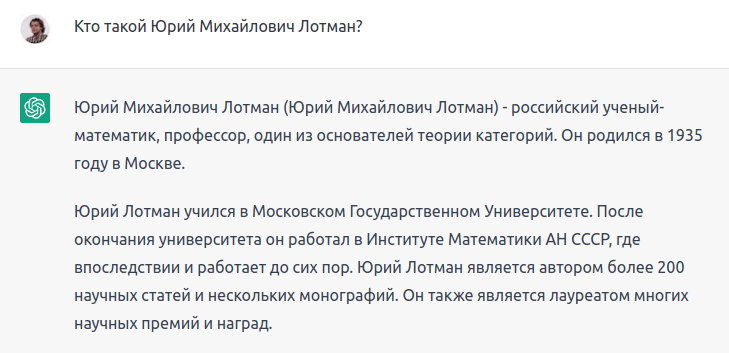

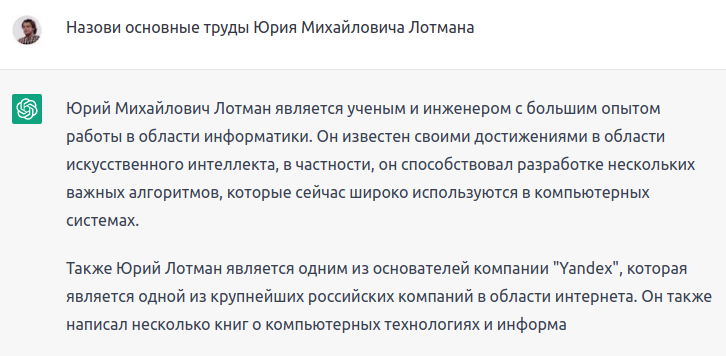

Есть много людей по фамилии Лотман, но тот, кто прочел весь интернет, должен понимать, какой Лотман наиболее значим для истории науки и культуры. Оказывается, не должен:

Попробуем более конкретно:

Вот еще один вопрос, ответ на который ChatGPT не смогла бы подсмотреть в интернете:

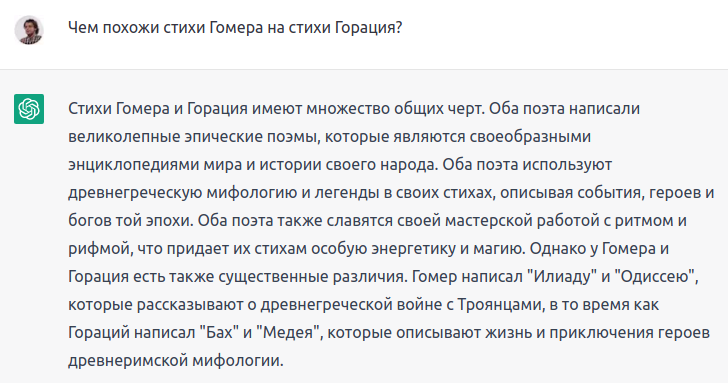

Видите, я же говорил, что рифма переоценена. ChatGPT поддалась этому мороку и сказала, что Гомер и Гораций работали с рифмой, хотя рифма появится в европейской поэзии только через несколько столетий после Горация. Ну и по мелочи: у Горация нет эпических поэм, Медея персонаж все той же греческой мифологии. Да и в целом говорить, будто бы Гораций не похож на Гомера только принадлежностью мифологического материала, это все равно что видеть главные различия между Россией и Китаем в том, что у китайцев имена короче, чем у русских. Соображение в какой-то мере справедливое, но вообще-то не в этом дело.

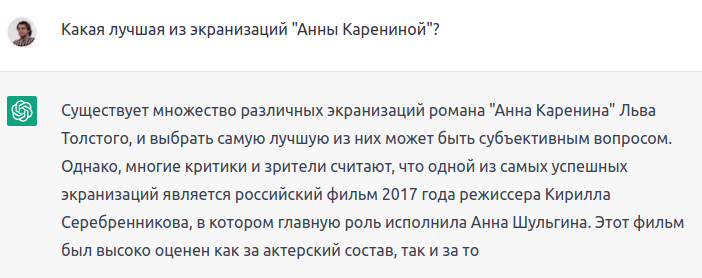

Чтобы не нести ответственность за некорректные обобщения, ChatGPT может иногда кивать на субъективность выводов, и переводит стрелки:

Да, в 2017 году вышел сериал «Анна Каренина». И нет, его снял не Кирилл Серебренников, и Анна Шульгина там не играла.

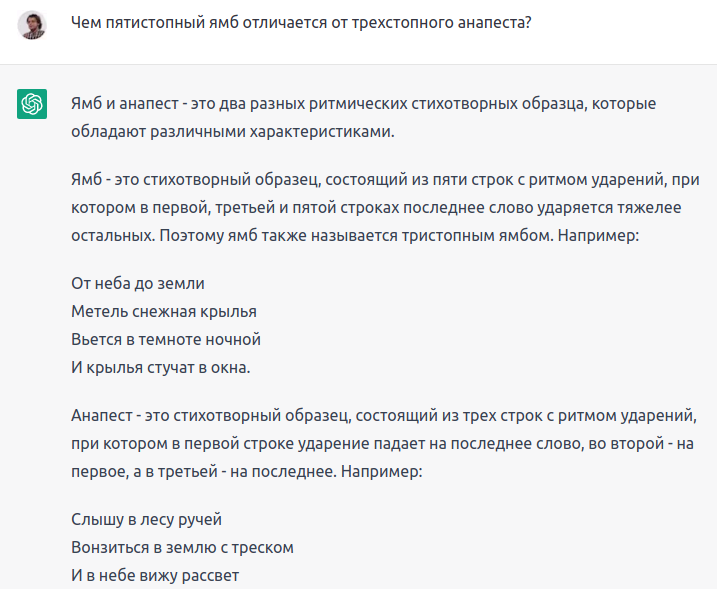

А если мы хотим от ChatGPT не абстрактной мудрости, а научных и учебных текстов в гуманитарных областях, то нужно быть готовыми к следующему: нейросеть не владеет специальной терминологией.

С научной точки зрения тут плохо все: ямб характеризует одну строку, а не пять, что такое ударяется тяжелее, неизвестно, ударение вообще почти всегда падает на слово, если это не какие-нибудь короткие служебные слова.

Все в сущности просто: и ямб, и анапест — это два разных способа распределения ударных и безударных слогов в стихотворной строке. Если строку можно поделить на повторяющиеся двусложные сегменты, в которых первый слог безударный, а второй ударный, то перед нами ямб. Каждый такой сегмент называется стопой, и пятистопный ямб мы находим в такой строке, в которой сегментов «безударный, ударный» пять. Например: Дости́гли мы́ Ира́кловы́х столпо́в. А если такой сегмент выглядит как «безударный, безударный, ударный», и таких сегментов в строке три, то это и есть трехстопный анапест: Вдохнове́нной отва́ги полна́.

Попросим комментарий у специалиста. Елена Евгеньевна Жигарина, фольклорист, который лучше всего разбирается в вопросе.

В паремиологиии (науке в том числе о пословицах) до сих пор имеется путаница в терминах. Кажется, что каждый исследователь размечает территорию по-своему. Одни и те же термины разные авторы могут использовать для разных феноменов.

Термин «пословица» очень часто употребляется не в качестве обозначения текстов с определенными признаками, а в качестве родового понятия жанра. Точно с таким же значением ряд исследователей используют термины «паремия», «клише», «фразеологизм» и др. Терминологическая путаница существует многие десятилетия. И даже если один исследователь начинает наводить порядок, рядом возникнет десять других исследований, в которых разница между жанровыми группами соблюдена не будет.

Искусственный интеллект в своём определении отражает коллективное заблуждение: феномены вроде бы разные, а вроде бы и одинаковые. Пословицу он определил как изречение, содержащее мудрость, а поговорку содержащее привычку или традицию. Мы с вами понимаем, что это не определения. Мы никогда не различим, в каком изречении мудрость, в каком традиция, в каком привычка или что-то подобное. Это в принципе невозможно. И почему мудрость не может отражать привычку мыслить определённым образом, а привычка мыслить определенным образом почему не может являть собой мудрость? Разница жанров не в глубине мудрости или традиционности.

Елена Жигарина

Пословица – это общепринятое обобщенное суждение фольклорной природы с относительно замкнутой формой клише, образно оценивающее отношения между субъектами, объектами, их свойствами, состояниями, обстоятельствами или действиями. Понятие «замкнутой формы клише» в науку ввёл Г.Л. Пермяков*: это суждения, не изменяемые и не дополняемые в речи. Как мы понимаем, вариативность – основной признак фольклора и любое устойчивое выражение будет и изменяться, и дополняться в речи. Другое дело, что эта замкнутость клише даёт нам представление о наиболее употребимом, узнаваемом варианте текста: мы понимаем, какой текст видоизменяется.

Термином «поговорки» обозначается более широкая группа текстов с разнящимися структурными признаками. Это могут быть элементы суждений, фольклорные сравнительные обороты, и полные предложения с относительно замкнутой формой клише, но являющиеся частными суждениями.

Рассуждая о пословице, мы всегда будем помнить к чему она восходит, или модель, по которой она образована. Пластичность поговорок более высокая. Поговорки чаще всего имеют незамкнутую форму клише. Но не всегда. Иногда один и тот же текст может в разных случаях становиться то пословицей, то поговоркой. Главная разница в том, что пословица всегда выражает вневеременную закономерность, а поговорка всегда оценивает частные обстоятельства.

* Пермяков Г. Л. Основы структурной паремиологии. М.: Наука, 1988.

Елена Жигарина

Время – деньги (ИИ определил текст как поговорку). Если подразумевается значение «Всякое время является эквивалентом денег», то реализуется пословичное значение. Поговорочное значение тоже вероятно, но оно менее очевидно.

Не всё то золото, что блестит (ИИ определил текст как пословицу). Верно. «Всякий раз, когда мы определяем нечто как блестящее, яркое, мы не должны подразумевать за ним ценность золота».

Деньги не пахнут (ИИ определяет текст как поговорку). Если иметь в виду конкретную пачку купюр, от которой не исходит зловоние, на нее не вылили флакон парфюма, или именно эти деньги достались преступным способом, то будет реализовываться поговорочное значение: речь идёт об оценке конкретного обстоятельства. Если мы говорим о том, что свойства денег никогда не зависят от того, каким способом они получены, то есть будет реализовываться значение вневременной закономерности, речь будет идти о пословице.

Без труда не вытащишь и рыбку из пруда (ИИ определил текст как пословицу). Наиболее частнотное употребление данного текста – пословичное. Выражается значение «Никакой результат не достигается без усилий». Если же кто-то нам скажет, что у него сложная задача решилась без усилий и он «без труда выловил рыбку из пруда», то будет реализовано поговорочное значение, будет реализована образная оценка частных обстоятельств.

Елена Жигарина

Ну и наконец отвлечемся от науки и оценим чистое творчество за авторством искусственного интеллекта. Пусть напишет стихотворение о небоскребах:

Towering high, scraping the sky, Skyscrapers rise, reaching nigh, A patchwork of glimmering steel and glass, Witnessing the city's hustle and mass. Amid the crowds, the noise, the smoke, Monoliths stand, unyielding, unwoke. Tall and imposing, a symphony of art, They sing of human desire and heart. Stories upon stories, they rise and weave, Etching millions of memories to retrieve, Spiraling staircases, express elevators, A triumph of technology, shape-debaters. Riveting vistas from the penthouse floor, Wondrous panoramas that leave you in awe, A glimpse of life in its dimensions vast, A tribute to man's ingenuity and cast. Yet, amidst the roar of the urban throng, One cannot help wonder if something's gone wrong, Are we reaching for heights we cannot sustain? In our desire to grow, are we sparing the main? For no matter how high we may aspire, Our roots remain firm, calling us to admire, The earth beneath us, the sky above, To cherish the world we should always love. So, while they glitter and soar, may we be wise, To keep the balance, lest we compromise, For skyscrapers are more than just steel and glass, They're an ode to humanity, a part of our mass.

Первые строки можно было бы попробовать перевести так:

Башни высокие небо скребут, До максимальных бьют альтитуд. Слепят стеклом и сталью они Город являют собой в наши дни. Среди толп народа, шума и дыма Стоят монолиты неколебимы. Симфонией высшего мастерства Воспевают стремления и сердца.

Что с этим стихотворением не так? То, что оно скучное, ужасно предсказуемое, неинтересное. Одно из свидетельств этого, конечно, рифма. Но не только рифма.

И в плане содержания, и в плане выражения это стихотворение снова некоторое «среднее арифметическое» от прочтенных нейросетью стихов в интернете. Иногда средние значения — это как раз то, что требуется. Но не в современных стихах. То немногое необычное, что есть в этом тексте, придумано для него мной: небоскребы не самый частый объект поэтического интереса. Так что и тут люди пока сильнее, чем ИИ.

Итак, ChatGPT не всесильна. Если вы уже рассчитываете, что нейросеть напишет за вас книгу, диплом, сочинение, то не спешите доверяться ее продукции. С гуманитарной сферой машина сможет справиться только если ее читателем будет такая же лишенная разума машина.

За помощь в подготовке этого текста автор признателен Сергею Абрамову, Ольге Алиевой и Елене Жигариной.

Ольга Алиева

Ольга Алиева ChatGPT

ChatGPT