От намерения к действию

Кто может выстраивать правила игры для учеников — можно им использовать ИИ или нет? Государство, экспертные организации, образовательные учреждения, преподаватели, родители? Или вообще это вопрос совести каждого ученика? Попробуем разобраться.

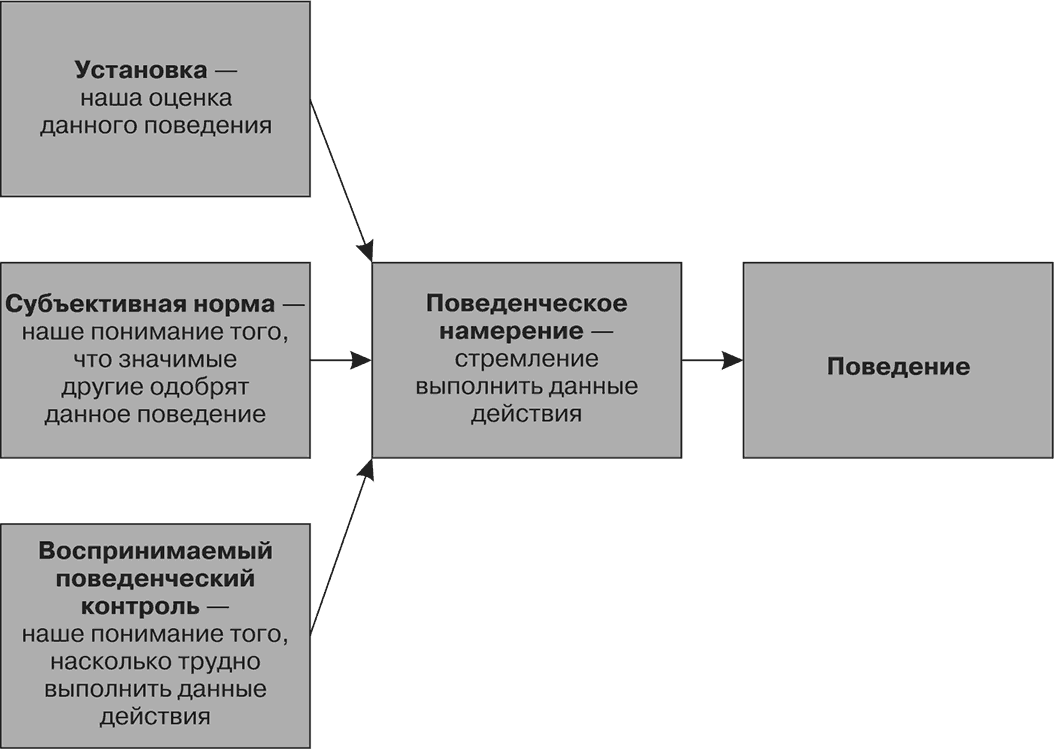

Для удобства начнём с модели, которая помогает понять, почему кто-то использует ИИ, а кто-то нет. Социальный психолог Исаак Айзен предложил теорию запланированного поведения (Theory of Planned Behavior). Согласно этой теории, любому действию предшествует намерение. Оно в свою очередь связано 1) с отношением самого человека к действию, 2) с отношением общества, и 3) с верой человека в наличие у него нужных способностей, возможностей и знаний.

Эта модель смещает внимание преподавателя с действия — «использовать ИИ или нет» к намерению. Преподаватель может помочь ученикам сформировать намерение или отказаться от него, открыто заявляя о своей позиции.

Есть такой мем: что на рисунке — забор или озеро? Пока учащимся не понятно отношение преподавателя к ИИ, им труднее корректировать своё поведение на его занятиях.

Как преподавателю разрешить использование ИИ?

Начнём с метафоры озера. Это когда преподаватель не просто разрешает использовать ИИ, а создаёт условия для его осмысленного применения, мягко направляя учащихся к корректному поведению.

Для этого можно оговорить правила работы на занятиях в устной форме. Для большей строгости их можно закрепить письменно в формате памятки или свода правил для отдельной дисциплины. Её важно разместить в доступе с другими материалами курса и обсудить в начале занятий, периодически возвращаясь к ней.

Э. и Л. Моллик в статье «Почему во всех занятиях вдруг стали применять ИИ» [3] предложили такую формулировку:

Я понимаю, что в работе над заданиями нашей дисциплины вы можете использовать технологии искусственного интеллекта [перечислить какие приложения]. На самом деле, некоторые задания даже потребуют этого. Обучение применению ИИ-технологий — это новый навык, и я предоставляю обучающие материалы для этих задач. Я буду рад встретиться с вами и помочь с освоением требуемых ИИ-инструментов в перерывах между занятиями или после занятий.

Однако вам стоит учитывать следующие условия и ограничения: (далее идут детали применения ИИ).

{Текст переведён с английского и адаптирован автором}

Больше примеров формулировок о создании доверительных отношений можно найти по ссылке.

Сверим предложенную формулировку с моделью запланированного поведения. Она отражает положительное отношение преподавателя к тому, чтобы студенты осознанно использовали нейросети. В результате намерение учеников применять ИИ-инструменты может усилиться. Однако одного намерения недостаточно, чтобы совершилось действие, поэтому преподаватели предлагают дополнительные инструкции и консультации, поощряя использование искусственного интеллекта.

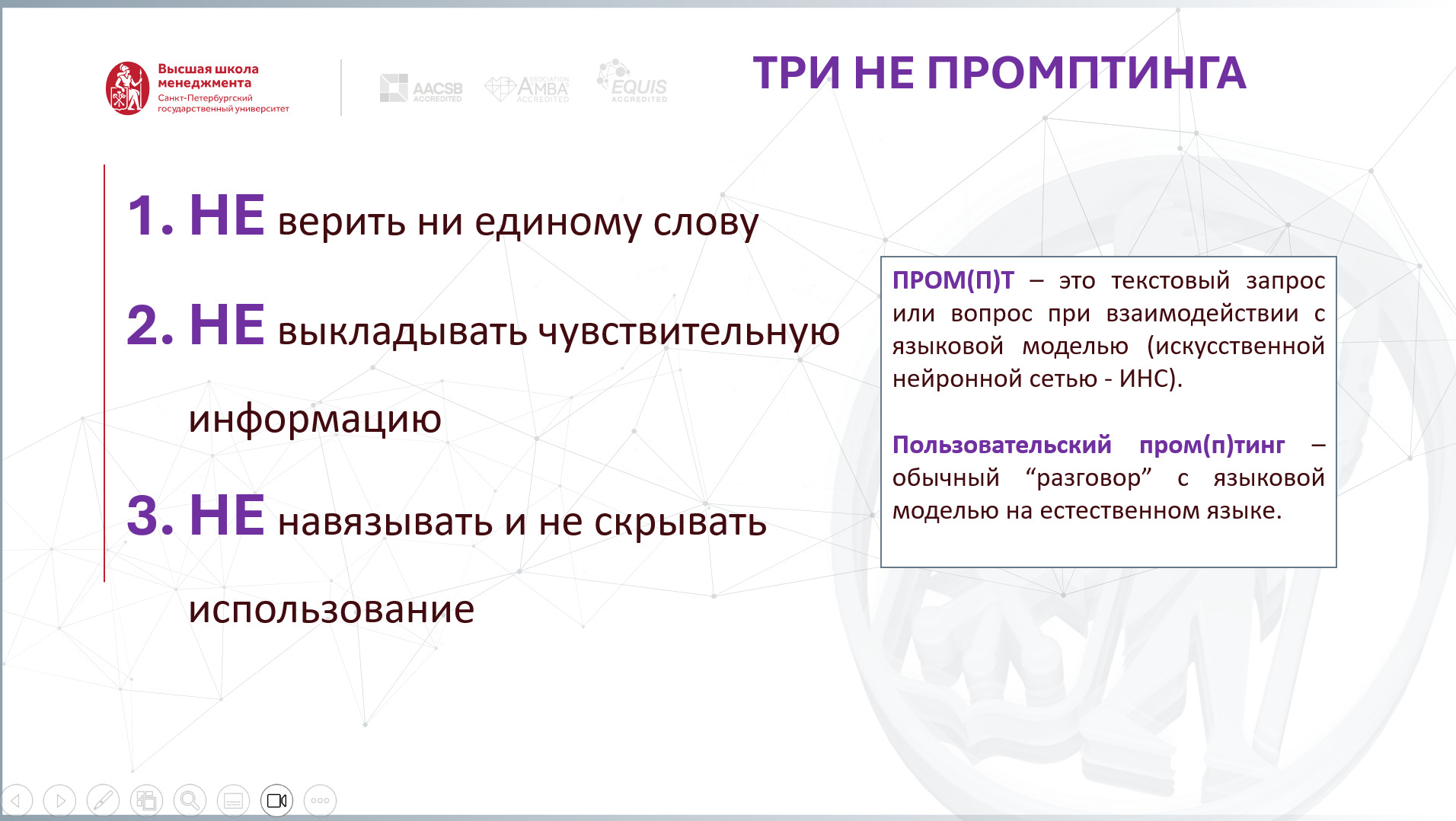

Далеко не все преподаватели готовы разрабатывать подробные гайды о том, как правильно применять нейросети на их занятиях. Можно ограничиться базовыми рекомендациями.

Разработать памятку для студентов можно с помощью ИИ-помощника. Например, сервис GUIDDE помогает сделать запись экрана, расшифровать текстовую инструкцию, после чего дает возможность поделиться публичной ссылкой с пользователями.

Помимо свода правил и памяток можно рассмотреть со студентами мемы об отношении к ИИ, его основных проблемах, о стереотипах в отношении ИИ или обсудить неудачные варианты его применения, как в статье «Как нарушить правила академической честности при написании контрольной работы».

Преподаватели обучают осознанному подходу и на собственном примере. Когда они показывают, как и для чего они использовали нейросети в своей работе, они помогают студентам развивать насмотренность и подсказывают им, как об этом говорить. Такие преподаватели включают ИИ-инструменты в задания и предоставляют обратную связь не только на результат, но и на процесс применения ИИ-помощников. В Центре преподавательского мастерства ВШМ СПГУ такой подход назвали ДУМai.

Как преподавателю запретить использование ИИ?

Вернёмся к метафоре забора из мема. Запрет на использование нейросетей нужно закреплять в нормативных документах, таких как программы учебных дисциплин, положения к оценочным процедурам, политика учебного заведения. Например, в Государственном университете Салема для курса «Мастерская писателя» используется такая формулировка:

- Вы можете применять технологии генеративного ИИ только тогда, когда это разрешено: каждое задание содержит указание о разрешенных целях использования ИИ-технологий. Некоторые задания категорически запрещают любое использование ИИ-технологий.

- Используйте ИИ-технологии для поддержки в обучении, а не для замены обучения: генеративный ИИ НИКОГДА не должен заменять ваше критическое мышление, обучение или написание писем в этом курсе. Например, ИИ можно использовать как инструмент для генерации идей, организации текста, улучшения ясности или краткости, поиска цитат (проверяйте их!), но он не должен генерировать тексты писем.

- Декларируйте и цитируйте любой вклад генеративного ИИ

- Помните: эта политика действует только для курса ENL 314 в этом семестре у этого преподавателя.

В этой подборке можно найти и другие примеры университетских политик по использованию генеративного искусственного интеллекта.

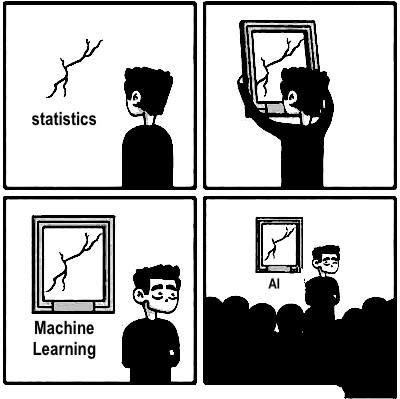

Читателю может показаться нелогичным, что в рамках темы про запрет использования ИИ приводится пример с его разрешением. На самом деле ИИ — это большое семейство технологий, за которыми стоит математика, статистика, теория вероятности … — все то, что мы обычно разрешаем, поощряем, ценим. И главное, эти технологии проникают в инструменты, которыми мы и так пользуемся, включая текстовые редакторы, переводчики, средства видео-конференц-связи, онлайн-доски, поисковики, музыкальные платформы, пропуск на территорию различных заведений, сервисы бронирования. И если вернуться к модели запланированного поведения, может так случиться, что человек применит ИИ без намерения и даже без понимания, что это был ИИ.

ИИ — это математика, статистика

Чаще всего в учебном процессе под запрет попадают именно генеративные технологии. Ориентиром здесь может выступить этический стандарт COPE (Code of conduct | COPE: Committee on Publication Ethics): не разрешается создание текста работы, данных, графиков с помощью генеративных технологий, если это не обусловлено выбранным методом.

Однако запрет порождает другую проблему: как отследить, что он соблюдался? ИИ-детекторам полностью доверять невозможно. Можно обратить внимание на косвенные маркеры использования нейросетей. Например, некоторые ИИ-помощники оставляют скрытые следы, такие как длинное или двойное тире, пробелы, которые не свойственны большинству текстовых редакторов, используют определённый шрифт, markdown-разметку.

Из примера про курс «Мастерская писателя» видно, что даже внутри одной дисциплины важна избирательность. Это объясняет, почему так трудно договориться об общих правилах для всего учебного заведения. Университеты, например, в своих политиках приводят общие рамки, указывая, что каждый преподаватель может их сужать, но не расширять. Однако наличие хотя бы таких политик безусловно создаёт точки опоры, которые преподаватели могут использовать в своих дисциплинах. Если политик или деклараций, меморандумов на уровне учебного заведения нет, а преподавателю важно найти правильные слова, чтобы ограничить использование нейросетей, можно обратиться к таким источникам:

- декларации университетов, например, ВШМ СПбГУ, НИУ ВШЭ, РУДН и других;

- материалы ЮНЕСКО и Альянса в сфере ИИ;

- документы государственных органов, например существует ГОСТ об ИИ в образовании;

- Национальная стратегия развития искусственного интеллекта на период до 2030 года.

Еще показательный пример создания точек опоры на уровне государства случился в Китае, где нейросети отключились на время экзаменов, чтобы учащиеся опирались на естественный интеллект.

Другим способом снизить намерение студентов использовать ИИ может стать обсуждение цифровой идентичности. Появилось много новых слов, которые обозначают последствия бездумного применения ИИ-технологий. Например, sloppers — те, кто излишне полагается на нейросетии и попадает в нелепые ситуации, халтурщики; workslop — имитация работы с помощью ИИ вместо реальной работы, халтура. Автор статьи вместе с коллегами из ВШМ СПбГУ, Еленой Завьяловой, Викторией Цыбовой изучает проблему гиперподключенности среди студентов вузов. Так, удалось обнаружить, что нейросети отнимают много времени, которое можно было бы уделить общению с близкими и друзьями. Другие исследователи говорят о том, что пользователю важно сохранить целостность личности в период появления «человека подключённого и достроенного» [4, 5].

Возвращаясь к примеру для курса «Мастерская писателя» хочется обратить внимание, что автор дисциплины оставил «дверь» для студентов, которая даёт им право использовать ИИ даже при полном запрете. Если они смогут обосновать, что ситуация требовала применить ИИ-технологию, это будет более допустимо, чем если они скроют использование ИИ.

Третий способ ограничить применение нейросетей в процессе обучения — больше обсуждать с учениками угрозы, связанные с ними. Репозиторий MIT The Al Risk Repository содержит, наверное, самый полный перечень рисков. Среди них, к примеру, есть риск дезинформации. Вокруг него в сети появилось много кейсов, которые можно обсудить с учениками. Среди недавних — кейс про ошибки в отчётности Delloitte, который обошёлся компании в очень большую сумму и принёс репутационные потери. Если коротко: соблюдение этических принципов трудно отследить.

Все эти решения работают только в том случае, если у преподавателя есть чёткая позиция в отношении ИИ. Как её выработать? В качестве ответа можно привести цитату из книги Э. Лукас и А. Баттиани «Логотерапия и экзистеницальный анализ сегодня» [5, с. 30]: «Постоянный…технический прогресс духовно необходим… Все зависит от того, будет ли поспевать за быстрым прогрессом ответственное отношение к новому, которое прогресс несёт с собой… Изобретения сами по себе нейтральны в плане ценностей… Пока совесть держит технику на поводке, она будет нашим благословением».

Список источников

- Ajzen I. The theory of planned behavior // Organizational behavior and human decision processes. 1991. Vol. 50. Issue 2. Pp. 179-211.

- Ajzen I., Cote N. G. Attitudes and the prediction of behavior // Attitudes and attitude change. 2008. Vol. 13. Pp. 289-305.

- Mollick E., Mollick L. Why All Our Classes Suddenly Became AI Classes [Электронный ресурс] // Harvard Business Impact. 2023. 09 Feb. URL: https://www.hbsp.harvard.edu/inspiring-minds/why-all-our-classes-suddenly-became-ai-classes (дата обращения 13.11.2025).

- Солдатова Г. У., Илюхина С. Н. Человек технологически достроенный: в поисках целостности //Культурно-историческая психология. 2025. Т. 21. №. 1. С. 13-23.

- Солдатова Г. У., Войскунский А. Е. Социально-когнитивная концепция цифровой социализации: новая экосистема и социальная эволюция психики // Психология. Журнал Высшей школы экономики. 2021. Т. 18. №. 3. С. 431-450.

- Баттиани А., Лукас Э. Логотерапия и экзистенциальный анализ: текущее состояние. М.Когито-центр, 2021. 351 с.