Влиятельная часть мирового IT-сообщества объявила массовый бойкот на фоне возродившегося течения Black Lives Matter. Но о предвзятости алгоритмов эксперты говорили и раньше, а причины недоверия крылись не только в предубеждениях технологии, но и в отсутствии правового регулирования киберслежки.Разбираемся, что не так с распознаванием лиц.

Как работает система

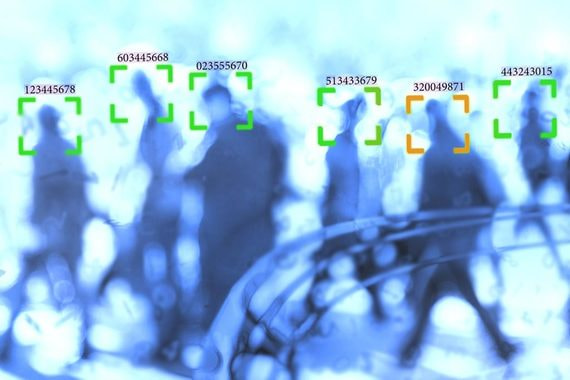

Индивидуальные отпечатки есть не только у пальцев, но и у наших лиц. Изображение с камер видеонаблюдения получает специально обученный алгоритм, который выделяет в кадре лицо прохожего. Затем в игру вступает технология распознавания и размечает несколько десятков ключевых точек на лице человека (keypoint face detection). Расстояние между глазами, форма скул, носа, губ и другие внешние данные позволяют определить особенности лица (а не лукист ли этот робот?). Полученный результат превращается в численный вектор, и каждый, на кого «поглядел алгоритм», приобретает числовой код лица или уникальный faceprint (отпечаток). Программа сравнивает код с базой отпечатков (подобно той, что есть у пальчиков), определяет соответствия и идентифицирует человека.

Где мы с этим сталкиваемся

Система распознавания лиц уже вовлечена в нашу повседневность. Мы используем faceprint для разблокировки смартфонов, верификации банковских карт, при онлайн платежах и даже в качестве билета на самолет (такое практикуют авиакомпании Delta и JetBlue). В последние годы эту технологию тестируют правоохранительные органы со всего мира, а в некоторых странах, например в Китае, (лидере по количеству камер наблюдения), она служит одним из основных средств борьбы с преступностью. Постепенно алгоритмы внедряют в общественных местах и транспорте, а с прошлой зимы и в некоторых школах Нью-Йорка.

Администрация учебных заведений создала базу с черным списком, в который входили нарушители правопорядка, сексуальные насильники, бывшие сотрудники, которым нельзя было посещать школы. Если система распознавала одного из них на территории, охранникам поступал сигнал тревоги и изображение нежелательного гостя. Сотрудник повторно сравнивал фото с камеры с базой данных, и если он подтверждал опасения алгоритма, сигнал автоматически перенаправлялся в полицию.

Почему систему называют злом

На первый взгляд все эти опции кажутся безобидными, ведь цель технологии — обеспечить безопасность. Алгоритм и вправду может упростить поиск преступников, ведь теоретически он способен опознать любого, чьи данные содержатся в базе. Но полностью довериться роботам пока нельзя: эффективность распознавания зависит от расы. Согласно исследованию Национального института стандартов и технологий (NIST), система неправильно идентифицируют афроамериканцев и азиатов в 10-100 раз чаще, чем представителей белой расы.

В январе 2020 полиция Детройта арестовала невиновного афроамериканца Роберта Уильямса из-за ошибки алгоритма распознавания лиц. Это был первый случай ложного задержания, который подкрепил опасения ученых.

Избавь мы роботов от предубеждений, могли бы претендовать на утопию без преступности в будущем? Отказ от предоставления технологий вызван не только цветом кожи, но и отсутствием законов, регулирующих использование алгоритмов. Американский союз гражданских свобод (ALSU) утверждает, что все это угрожает основным конституционным ценностям. Постоянная слежка за людьми посягает на неприкосновенность частной жизни. Власти без нашего ведома могут узнать куда мы ходим, с кем общаемся и каковы наши привычки.

Скандальный алгоритм

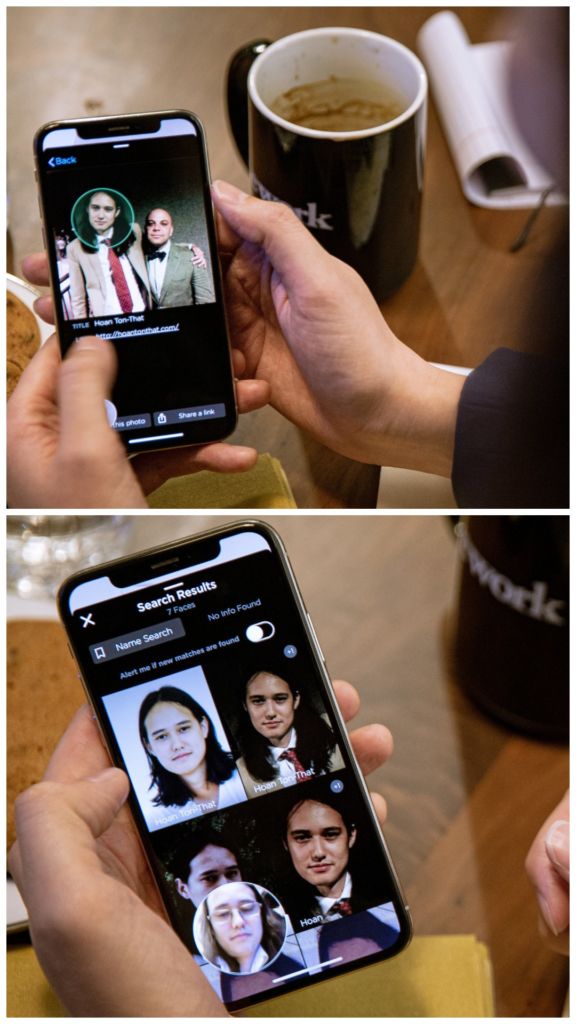

В январе 2020 года The New York Times опубликовали расследование о приложении для распознавания лиц от компании Clearview AI. Организация продавала программу, база данных которой насчитывает более 3 миллиардов фотографий из интернета и социальных сетей, правоохранительным органам и некоторым частным компаниям для обеспечения безопасности. Для идентификации достаточно было загрузить снимок человека, после чего приложение выдавало все общедоступные фото с разных ресурсов, включая изображения, которые были удалены из соцсетей. Кроме имени и возраста можно было узнать, где человек жил, с кем общался и кого знал.

Независимые эксперты еще не оценивали эффективность работы программы. Тем не менее базу данных используют более чем 600 органов охраны правопорядка в США и Канаде. При этом никто не регулирует, как именно полиция использует алгоритм.

«Представьте себе негодяя из правоохранительных органов, который хочет выследить потенциальных романтических партнеров, или иностранное правительство, использующее программу, чтобы раскопать секреты о людях, шантажировать их или бросить в тюрьму», — сказал Эрик Голдман, директор юридического института высоких технологий Университета Санта-Клары.

Американский союз гражданских свобод подал в суд на технологию Clearview AI из-за нарушения неприкосновенности частной жизни. В докладе сказано, что отпечаток лица, как и другие биометрические данные, невозможно изменить или скрыть. Поэтому сбор и хранение faceprint делает людей уязвимыми и лишает их возможности сохранить анонимность. Система может мгновенно опознать людей на митинге, в молитвенном доме, в приюте для жертв бытового насилия или на собрании анонимных алкоголиков. Публикуя свои фотографии в соцсетях, мы делаем их общедоступными, но все равно не ждем, что окажемся в правительственной базе данных.

Что было дальше?

После расследования The New York Times 40 общественных организаций в США призвали запретить технологию распознавания лиц. Clearview подверглись жесткой критике, ведь загрузка и хранение изображений для слежки противоречит политике большинства соцсетей. Facebook, Twitter и YouTube направили письма с требованием прекратить использовать фото и видео с их сайтов.

В Сан-Франциско, Сомервилле и Окленде уже введен запрет на использование технологии распознавания лиц. Эксперты ожидают, что остальные города США последуют их примеру. Ученые настаивают на принятии федерального закона, который будет регулировать использование алгоритмов полицией и защищать граждан от вмешательства в частную жизнь. Пока технологии распознавания лиц никем не контролируются. И все мы будто находимся под прицелом телекранов и глаз Большого Брата.

Источники

- The New York Times «The Secretive Company That Might End Privacy as We Know It»

- CNN «This man says he’s stockpiling billions of our photos»

- CNN «The ACLU sues Clearview AI, calling the tool an ‘unprecedented violation’ of privacy rights»

- CNN «ACLU sues federal government over surveillance from facial recognition technology»

Посмотреть на работу приложения Clearview можно здесь